KI | Adversarial Attacks

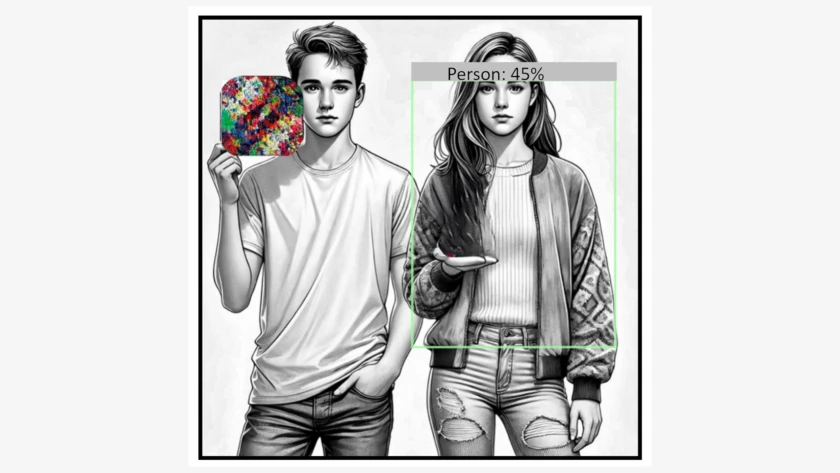

Adversarial Attacks sind faszinierend und beunruhigend zugleich. Durch gezielt manipulierte Eingaben, sogenannte Adversarial Examples, lassen sich Schwachstellen in maschinellen Lernmodellen ausnutzen, um die KI in die Irre zu führen.