KI | Neuronale Netze

Kurze Informationen und Hinweise für den Unterricht

Täuschend echte Videos, Bilder und Tonaufnahmen, die vollständig von KI-Systemen generiert oder manipuliert werden, sogenannte Deepfakes, eröffnen eine neue Dimension digitaler Täuschung. Sie bedrohen Demokratie, vergiften gesellschaftliche Debatten, werden zu Unterhaltungszwecken genutzt und reichen bis ins Klassenzimmer. Wie können wir dem begegnen?

Der Begriff „Deepfake“ setzt sich aus „Deep Learning“ - einer Methode des maschinellen Lernens - und dem Wort „Fake“ zusammen. Durch die rasante Weiterentwicklung dieser inzwischen selbst für Laien nutzbaren KI-Technologien wird es immer leichter solche Fälschungen zu erstellen – und zugleich zunehmend schwieriger, zwischen realen Aufnahmen und Fälschungen zu unterscheiden (Walter, 2023).

Von Filmtricks zu KI-Täuschungen

Die Manipulation von Bild-, Ton- und Filmmaterial ist keineswegs neu; bereits vor Jahrzehnten kamen vergleichbare Techniken in der Filmproduktion zum Einsatz (O'Sullivan, 2019). Erst mit KI-Systemen hebt sich das Ganze jedoch auf ein völlig neues Level – und dank benutzerfreundlicher Tools kann heute praktisch jede und jeder Deepfakes erstellen.

Gefährdungspotenzial – Missbrauch und Kriminalität

KI-generierte Memes und Sticker: Mit Smartphone-Apps entstehen in Sekunden Bilder, die Kindern oder Lehrkräften falsche Aussagen in den Mund legen und sie bloßstellen. Solche Deepfakes verbreiten sich rasant in Klassenchats, befeuern Cybermobbing und untergraben das Vertrauen in echte Quellen, noch bevor Unterricht oder Aufklärung greifen kann.

Deepnudes: Anfang 2024 überschwemmten Deepfake-Pornovideos der Sängerin Taylor Swift die sozialen Medien - ein drastisches Beispiel dafür, wie sich solche Fälschungen in kürzester Zeit millionenfach verbreiten können (Heikkilä, 2024). Rund jedes fünfte Deepfake-Video ist pornografischer Natur (Tammekänd, 2020) – häufig sind Mädchen und Frauen betroffen, selbst solche, die nie in der Öffentlichkeit standen, deren Fotos jedoch online kursieren (Hao, 2021). Damit wächst das Risiko für Cybermobbing und Sexting-Attacken, bei denen Deepfakes die Würde Einzelner - sowohl Prominenter als auch Schülerinnen, Schüler oder Lehrkräfte gleichermaßen - nachhaltig verletzen können (Schmidt, 2024).

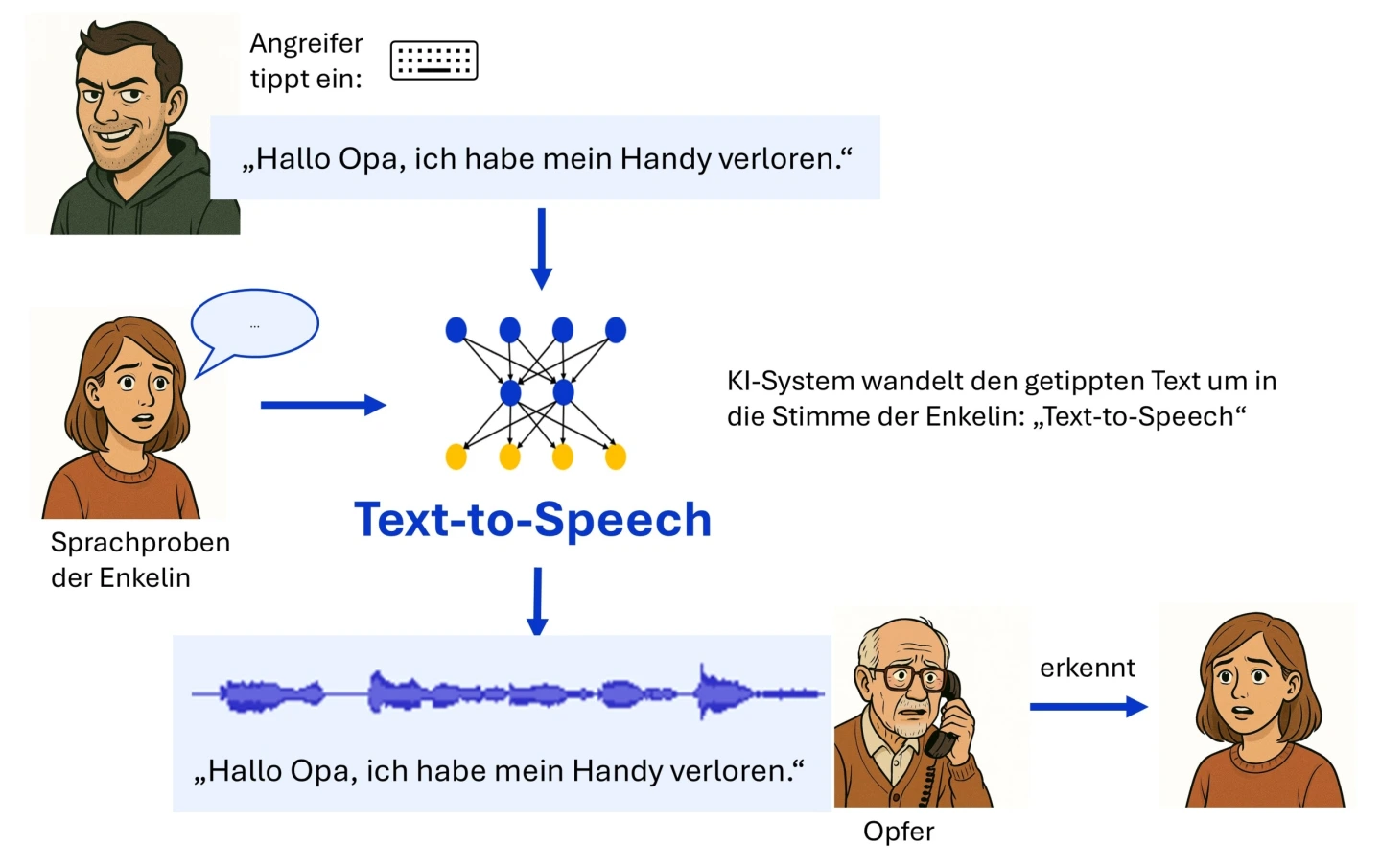

Telefonbetrug: Mithilfe perfekt imitierter Stimmen werden ahnungslose Opfer, oft ältere Menschen, getäuscht und zur Überweisung hoher Geldbeträge verleitet (Häusler, 2024).

Politische Desinformation: Im Januar 2024 erhielten Wählerinnen und Wähler in New Hampshire täuschend echte KI-generierte Anrufe mit einer nachgeahmten Stimme von Präsident Joe Biden, die sie aufforderte, nicht an den Vorwahlen teilzunehmen (Steck, 2024). Deepfakes bergen ein enormes Potenzial für politische Manipulation und Desinformation, wie den gezielten Rufmord von Kandidatinnen und Kandidaten bei Wahlkämpfen (Pawelec, 2024).

Harmlose oder sogar nützliche Einsatzfelder

KI-Synchronisation: Mit der Fähigkeit, Stimmen realistisch zu imitieren, lassen sich Reden oder Lernvideos in Echtzeit in andere Sprachen übertragen, während Klangfarbe und Sprechrhythmus der ursprünglichen Stimme erhalten bleiben. Dasselbe Verfahren wird bereits bei der Filmsynchronisation erprobt – etwa beim chinesischen Arthouse-Film Black Dog – Weggefährten, der 2024 komplett per KI vertont wurde und damit eine lebhafte Debatte über Echtheit und Künstlichkeit auslöste (Wiedemann, 2025).

Bildung: Geschichte kann lebendig werden, indem anschauliche Portraits von historischen Persönlichkeiten generiert werden, mit denen plausible Interviews geführt werden (arcatech, 06.2025).

Unterhaltung: Mit Deepfake-Tools entstehen heute in Sekunden witzige Clips, in denen Stars plötzlich in Kultfilmszenen auftauchen oder gealterte Schauspielerinnen oder Schauspieler digital verjüngt werden. Die nötigen Tools laufen auf fast jedem Smartphone – kein Wunder, dass solche Spielereien längst ein Social-Media-Trend sind (Brauer, 2024).

Softfakes: Ein eindrucksvolles Beispiel für sogenannte „Softfakes“ – also weniger täuschende, bewusst erkennbare digitale Veränderungen - stammt aus dem indischen Wahlkampf 2024: Ein KI-generierter Avatar von Premierminister Narendra Modi sprach Wählerinnen und Wähler direkt mit Namen an und erschien über einen Messenger-Dienst in mehr als zehn Amtssprachen auf ihren Mobilgeräten. Diese personalisierten Botschaften wurden mithilfe von KI-Tools erstellt, die aus wenigen Minuten Ausgangsmaterial detailgetreue digitale Kopien einer Person inklusive Stimme generieren konnten (Pawelec, 2024).

Fazit – Balance zwischen Risiko und Nutzen

Deepfakes eröffnen neue Formen von Missbrauch, Manipulation und Betrug, bieten aber zugleich Potentiale für kreative, pädagogische und technische Anwendungen. Politik, Bildung und Gesellschaft stehen vor der Herausforderung, einen verantwortungsvollen Umgang mit dieser Technologie zu finden.

Deepfakes sind zu unterscheiden von Cheap-Fakes (auch Shallow-Fakes): Cheap-Fakes entstehen ohne KI-Technologien – etwa indem man Videoausschnitte kürzt, die Wiedergabegeschwindigkeit verändert oder Bilder mit einer entsprechenden Software bearbeitet. Deepfakes dagegen werden von KI-Systemen erzeugt, die Gesichts-, Körper- oder Stimmmerkmale aus vielen Aufnahmen lernen und daraus täuschend echte Medien zusammensetzen. Auch wenn die Grenze zwischen beiden Formen nicht immer klar erkennbar ist, bleibt ihre Wirkung ähnlich: Beide können unterhalten – oder gezielt zur Desinformation und Rufschädigung missbraucht werden (Jonas, 2022).

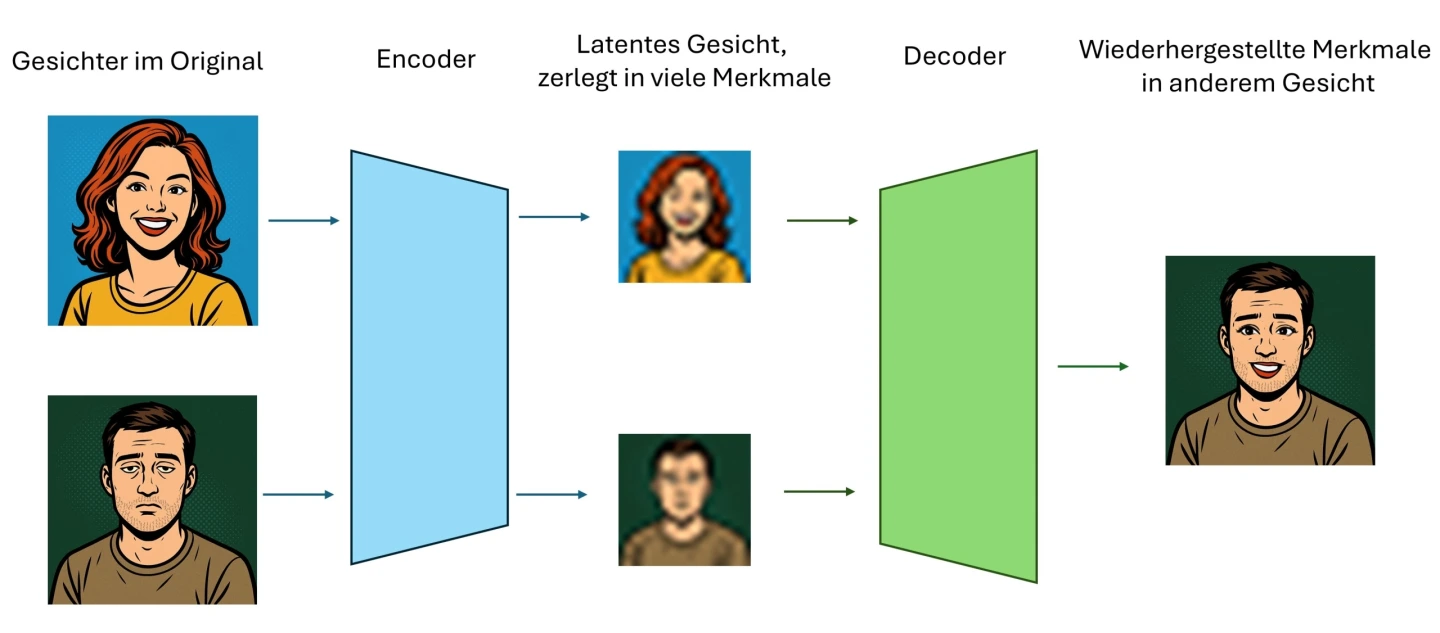

Deepfakes entstehen durch Computerprogramme, die Methoden Künstlicher Intelligenz (KI) nutzen. Zuerst „lernt“ das Programm das Gesicht oder die Stimme einer Person kennen. Dafür bekommt es viele Bilder, Videos oder Tonaufnahmen. Ein Teil des KI-Systems (der „Encoder“) zerlegt das Gesicht oder die Stimme in wichtige Merkmale. Ein anderer Teil (der „Decoder“) setzt diese Merkmale später wieder zusammen – aber zum Beispiel in einem neuen Video.

So entsteht beim „Face-Swap“ ein neues Bild, in dem das ursprüngliche Gesicht durch das einer anderen Person oder Teilen davon ersetzt ist. Das Programm vergleicht dabei das Ergebnis ständig mit dem Original und verbessert sich in vielen Durchläufen (Iterationen).

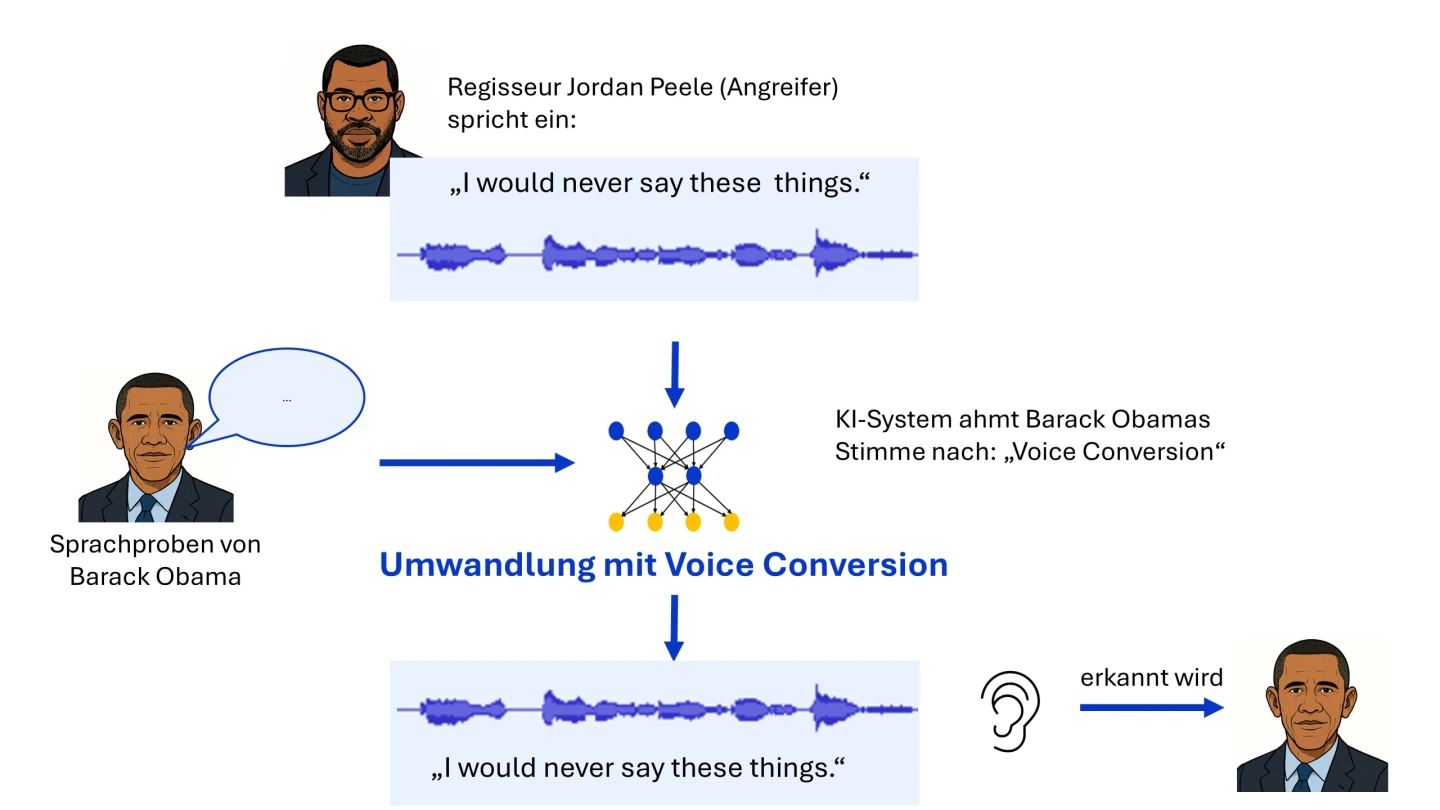

Auch Stimmen können gefälscht werden. Dabei lernt die KI aus vielen Sprachaufnahmen, wie eine bestimmte Stimme klingt. Anschließend kann sie neue Sätze in genau dieser Stimme sprechen lassen. So hören sich Deepfake-Stimmen täuschend echt an (Deutsches Forschungszentrum für Künstliche Intelligenz, 2025).

Unterschiedliche Techniken zur Erstellung von Deepfakes

Deepfakes basieren nicht auf einer einzigen Methode, sondern auf verschiedenen Verfahren, die je nach Anwendungsfall unterschiedliche Schwerpunkte setzen – von der Audiomanipulation über Gesichtsaustausch bis hin zur vollständigen Körperanimation. Nachfolgend ein Überblick über die gängigsten Ansätze:

Ein bekanntes Beispiel für das Nachahmen einer Stimme mithilfe von KI ist der Video-Clip You Won’t Believe What Obama Says In This Video. Darin scheint der ehemalige US-Präsident Barack Obama seinen Nachfolger Donald Trump zu beleidigen. Tatsächlich stammt die Aufnahme jedoch vom Schauspieler und Regisseur Jordan Peele, dessen Stimme per Deepfake-Technologie auf Obamas Klangfarbe umgewandelt wurde (muthmedia, 2025).

Beim Fälschen von Stimmen unterscheidet man im Wesentlichen zwei Verfahren: Text-to-Speech und Voice Conversion. Im genannten Video-Clip ist Obamas geklonte Stimme ein Beispiel für Voice Conversion. Hierbei wird das ursprüngliche Audiosignal – in diesem Fall die Aufnahme von Regisseur Jordan Peele – gezielt so verändert, dass es nach Obamas Stimme klingt. Wortwahl und Intonation bleiben erhalten, während sich allein die stimmliche Charakteristik ändert.

Bei Text-to-Speech hingegen wandeln KI-Systeme geschriebenen Text in gesprochene Sprache um. Für eine authentische Stimmimitation genügen oft schon wenige kurze Sprachproben, die sich leicht aus sozialen Netzwerken oder anderen Onlineportalen beschaffen lassen. Ein anschauliches Beispiel dafür sind sogenannte „Schockanrufe“. Dabei geben sich Betrüger am Telefon als Vertrauenspersonen (z. B. Angehörige) aus und nutzen dazu KI-generierte Stimmsamples, um ihre Opfer zu täuschen (Häusler, 2024). Die Angreifer wandeln zuvor festgelegte Texte in scheinbar von der Vertrauensperson gesprochene Sprache um. So können sie nahezu jede gewünschte Aussage in der Stimme einer beliebigen Person erzeugen (Bundesamt für Sicherheit in der Informationstechnik, 2025).

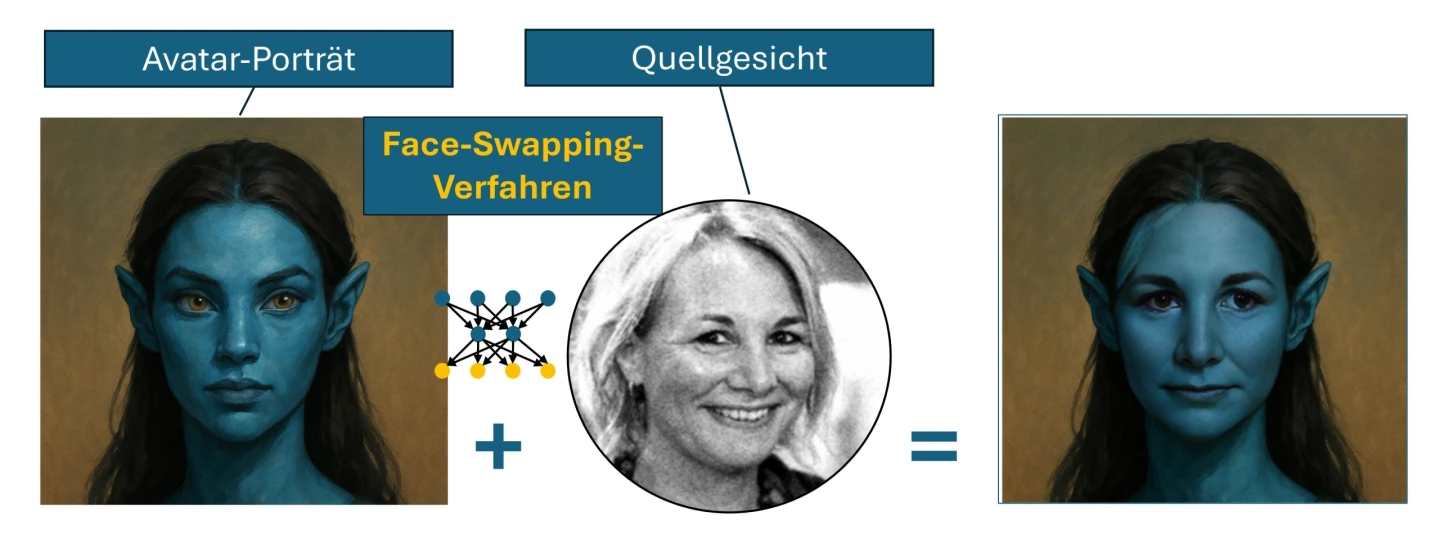

Face Swapping bezeichnet ein KI-gestütztes Verfahren, bei dem das Gesicht einer Person - hier ein Avatar-Portrait - in einem Bild oder Video nahtlos durch das Gesicht einer anderen realen Person, hier dem Quellgesicht, ersetzt wird. Zuerst wird dazu das Quellgesicht vermessen: ein KI-Tool erkennt Referenzpunkte im Gesicht, Mimik und Lichtverhältnisse. Diese Daten werden auf die entsprechenden Punkte im Avatar-Porträt übertragen und dort geometrisch sowie farblich angepasst. Anschließend ersetzt das Quellgesicht das ursprüngliche blaue Avatar-Gesicht, wobei Kanten geglättet und Schatten angeglichen werden. So sieht es aus, als hätte der Avatar von Anfang an das neue Gesicht getragen. Das ist nicht nur im Standbild sondern auch live im Videochat möglich (acatech, 2025).

Bei Face Reenactment wird im Gegensatz zum Face Swapping nicht die Identität einer Person vertauscht, sondern „nur“ ihre Mimik, Kopfbewegung oder sogar der Blick auf ein anderes Gesicht übertragen. Die Technik analysiert die Gesichtspunkte einer Person – das kann eine Lehrkraft vor der Webcam sein – und berechnet daraus Bewegungsparameter. Diese Parameter steuern in Echtzeit das Gesicht einer Ziel-Person im Video, z. B. eine historische Persönlichkeit, eine Comic-Figur oder sogar die Lehrkraft selbst in einer früheren Aufnahme (acatech, 2025).

Viele KI-Anwendungen, die oben genannte Methoden nutzen, arbeiten inzwischen auf gewöhnlicher Laptop-Hardware, benötigen nur noch ein Bild und einen Text als Eingabe und liefern nahezu fotorealistische Resultate. Fremdsprachen- oder Geschichtsunterricht können so durch „sprechende“ Porträts lebendig werden (HeyGen, 2025).

Problematisch ist, dass die Glaubwürdigkeit von Videomaterial sinkt, weil Gestik und Lippensynchronität kein Beweis mehr für Authentizität sind. Daher gehört Face Reenactment in jede Medienkompetenzeinheit: Wer Quellen bewertet, sollte nach inkonsistenter Beleuchtung, fehlerhaften Schatten oder fehlendem Augenblinzeln Ausschau halten.

Gesichtsgeneratoren erzeugen teilweise oder vollständig künstliche Personenabbilder, die in der Realität nicht vorkommen. Grundlage dafür sind Generative Adversarial Networks (GANs). GANs sind Computerprogramme, die aus vielen Beispielbildern lernen und daraus eigene, ähnliche Bilder erzeugen. Die damit erzeugten Figuren werden etwa für die Animation von Charakteren in Videospielen und Filmen eingesetzt oder fungieren in VR-Umgebungen als virtuelle Gesprächspartner (Karaboga, 2024).

Ein anschauliches Beispiel ist die Webseite thispersondoesnotexist.com, die bei jedem Refresh ein neues, GAN-basiertes Porträt liefert, das kaum von einem echten Foto zu unterscheiden ist (Vincent, 2019).

Wie leicht solche Bilder täuschen können, zeigte CORRECTIV.Faktencheck 2021: Die Redaktion enttarnte ein Netzwerk von Facebook-Accounts rund um die erfundene Zeitung „NRW Kurier“. Der Betreiber gab an, für seine Figuren Fotos aus Online-Tools zu nutzen, „die Bilder von Personen erzeugen, die in Wahrheit nicht existent sind“ – perfekte Avatare für Desinformation (Echtermann, 2021).

Schon mit einfachen Prompts lassen sich Deepfakes erzeugen: Wer einem Bild-Generator präzise Vorgaben zu Motiv, Stil und Stimmung gibt, erhält fotorealistische Ergebnisse, die echte Aufnahmen vortäuschen können. Studien zu KI-gestützter Kommunikation erläutern, wie solche maßgeschneiderten Prompts politische Botschaften oder Werbebilder besonders überzeugend erscheinen lassen (Kruschinski, 2025).

Dass dies praktisch funktioniert, zeigte 2023 das virale Daunenmantel-Bild von Papst Franziskus: Es entstand komplett per Prompt in einem Bildmodell und wurde von Faktenprüfern als Fälschung entlarvt (Kutzner, 2023). Das hier gezeigte Bild von Papst Leo XIV im weißen Daunenmantel wurde kreiert mit dem Prompt: „Erstelle eine Aufnahme von Papst Leo XIV. in einem weißen Daunenmantel mit einer Kette mit einem Kreuzanhänger um den Hals. Er steht im Sonnenlicht vor dem Vatikan, der Hintergrund ist verschwommen, fotorealistischer Stil.”

Deepfakes lassen sich heute mithilfe von KI-Methoden in kürzester Zeit erstellen und sind visuell wie akustisch so überzeugend, dass selbst Fachleute sie nur schwer von authentischem Material unterscheiden können. Jedem Fortschritt bei Deepfake-Detektionssystemen steht dabei ein ebenso großer Fortschritt neuer Manipulationstechniken gegenüber, sodass das Erkennen zu einem dauerhaften Katz-und-Maus-Spiel wird. Selbst spezialisierte Prüftools verfehlen unbekannte Varianten häufig, produzieren Fehlalarme und erreichen in der Praxis keine hundertprozentige Trefferquote (Müller, 2024).

Weil audiovisuelle Inhalte traditionell hohes Vertrauen genießen und sich viral verbreiten, erreichen Deepfakes die Öffentlichkeit oft lange vor Faktenchecks. Das nährt Befürchtungen vor politischem Missbrauch und einer Gefährdung demokratischer Prozesse (Pawelec, 2024).

Weltweit häufen sich Fälle, in denen Deepfakes in Wahlkämpfen eingesetzt werden – etwa diffamierende Videos in Argentinien (2023), ein Audio-Fake gegen den slowakischen Spitzenkandidaten Michal Šimečka kurz vor der Wahl (2023) oder sexualisierte Deepfakes, die den türkischen Präsidentschaftskandidaten Muharrem İnce zum Rückzug bewegten (2023). Auch bei den US-Wahlen 2024 kursierten Biden-Robocalls, Fake-Videos des Republican National Committee und KI-generierte Montagen von Kamala Harris. Obgleich kein Urnengang eindeutig gekippt wurde, zeigen die Beispiele, wie leicht sich Stimmungen in den letzten Wahlkampftagen beeinflussen lassen – insbesondere mit schwer identifizierbaren Audio-Deepfakes (Pawelec, 2024).

Der dauerhafte Schaden entsteht weniger durch einzelne erfolgreiche Fälschungen als durch den schleichenden Vertrauensverlust: Je öfter Deepfakes bekannt werden, desto schneller zweifeln Bürgerinnen Fotos, Videos oder Tonaufnahmen an – selbst wenn sie echt sind. Gleichzeitig können Machtinhaber belastendes Material als angebliche Fälschung abtun („"The Liar’s Dividend“), wie etwa Donald Trump 2024, als er ein Foto mit vielen pro-Harris-Anhängern als manipuliert bezeichnete. So wird die journalistische Überprüfbarkeit von Informationen und die Rechenschaftspflicht politischer Akteure massiv erschwert (Pawelec, 2024).

Wiederholt aus dem Ausland verbreitete Deepfakes verunsichern Wählerinnen und Wähler und schwächen das Vertrauen in die Parteien. Seit dem russischen Angriff auf die Ukraine 2022 kursieren manipulierte Videos und Audiodateien in der militärischen wie geopolitischen Kommunikation; sowohl pro-russische Propagandanetzwerke als auch ukrainische Akteure nutzen diese Mittel. Ein vergleichbares Muster zeigt sich im Gaza-Konflikt, wo Deepfakes die ohnehin polarisierten Informationsräume zusätzlich destabilisieren (Pawelec, 2024).

Deepfakes dienen gezielt dem Rufmord in Politik und Journalismus. Ein bekanntes Beispiel ist die indische Journalistin Rana Ayyub, die 2018 durch manipuliertes Material diffamiert wurde. Solche Angriffe können ganze Bewegungen einschüchtern und kritische Stimmen verstummen lassen (Pawelec, 2024).

Bislang lässt sich nur selten ein direkter Einfluss einzelner Deepfakes auf Wahlergebnisse nachweisen, doch ihre Gesamtwirkung schwächt das Vertrauen in Medien, Institutionen und demokratische Entscheidungsprozesse. Mit zunehmender Qualität und Verbreitung KI-basierter Werkzeuge geraten insbesondere regionale Wahlen stärker in Gefahr – vor allem dort, wo journalistische Korrekturmöglichkeiten begrenzt sind (Pawelec, 2024).

Faktencheck-Plattformen decken Fälschungen auf und stellen ihr Vorgehen transparent dar. Ist man unsicher, ob ein Bild, Audio oder Video gefälscht ist, dann kann man das zur Überprüfung dort melden. Einige typische Faktenchecker sind: Correctiv, dpa‑Faktencheck, AFP‑Faktencheck, #Faktenfuchs (BR), Mimikama, ARD‑Faktenfinder, DW-Faktencheck und Volksverpetzer.

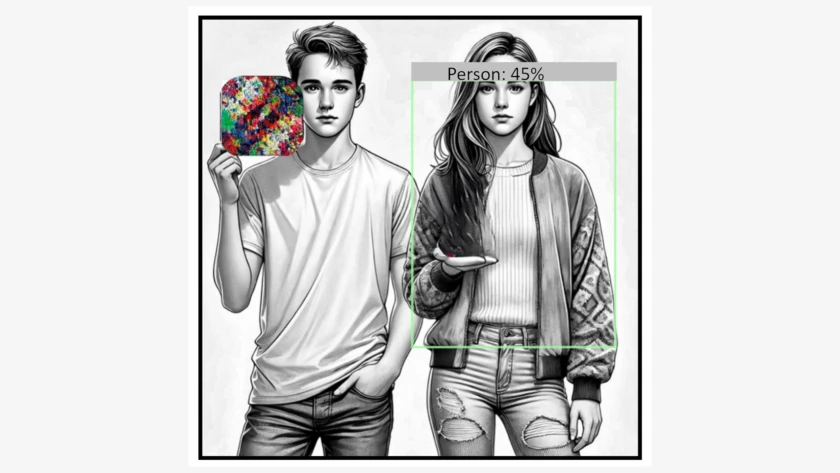

Medienbildung ist die beste Verteidigung: Schulen und Redaktionen sollten Deepfake‑Detektoren, Bildforensik‑Tools und einfache Verifikationsschritte, wie Bilderrückwärtssuche, Überprüfen der Metadaten oder Kontextsuche vermitteln, damit man zweifelhafte Inhalte schnell prüfen kann.

Regulierung & Kennzeichnung

Mit dem EU‑KI‑Gesetz (AI Act) und dem Digital Services Act (DSA) verpflichtet die EU große Online‑Plattformen, Risiken von KI‑Systemen aktiv zu minimieren und KI‑generierte Inhalte klar als solche auszuweisen. Betreiber von Social Media Plattformen und Online-Medien müssen Hinweisen auf Deepfakes nachgehen, verdächtige Beiträge priorisiert prüfen und umfassende Transparenzberichte vorlegen. Auch Anbieter von KI‑Generatoren unterliegen einer Offenlegungspflicht. Parallel läuft die Debatte über verpflichtende digitale Wasserzeichen, damit die Herkunft und Unversehrtheit von KI‑Unterstützung generierten Medien jederzeit überprüfbar bleiben (Karaboga, 2024).

Rechtliche Durchsetzung

Wer von einem Deepfake betroffen ist, kann sich bereits heute auf bestehende Gesetze zu Persönlichkeits‑, Urheber‑ und Strafrecht berufen. Doch Gerichtsverfahren dauern oft lange und werden kompliziert, wenn die Täterinnen oder Täter im Ausland sitzen. Fachleute fordern deshalb klare Regeln: Online‑Plattformen sollen Fakes nach einem Hinweis schnell löschen müssen. Betroffene sollen besseren Schutz erhalten und Beratungsstellen sollen leicht erreichbar sein (Karaboga, 2024).

Technische Lösungen

Programme, die Deepfakes automatisch erkennen, bleiben wichtig. Noch mehr Sicherheit versprechen digitale Herkunftsstempel: Wenn ein Foto oder Video schon bei der Aufnahme eine Art Echtheits‑Signatur erhält und diese bis zum Hochladen erhalten bleibt, kann man später besser nachvollziehen, ob die Datei verändert wurde (Müller, 2024).

Täuschend echte Videos, manipulierte Stimmen, KI-generierte Bilder: Deepfakes stellen eine wachsende Herausforderung für unsere Informationsgesellschaft dar. Gerade junge Menschen müssen lernen, diese Technologien einzuordnen und zu hinterfragen. Schule als Ort, wo man Wissen und Kompetenzen erwirbt, kann hier einen entscheidenden Beitrag leisten.

Die folgenden Unterrichtsmaterialien unterstützen Sie dabei, Deepfakes im Unterricht verständlich und reflektiert zu thematisieren. Sie fördern Medienkompetenz, regen zum kritischen Denken an und ermöglichen es Schülerinnen und Schülern, sich durch Faktenchecks, Rollenspiele oder den praktischen Umgang mit KI-Tools aktiv mit Desinformation auseinanderzusetzen.

Denn: Wer die Mechanismen hinter Deepfakes versteht, ist besser vor Manipulation geschützt.

Die Materialien der Bundeszentrale für politische Bildung (bpb) helfen dabei, Schülerinnen und Schüler für die Auswirkungen von Deepfakes auf Wahlen zu sensibilisieren und sie darin zu stärken, Verantwortung für ihre politische Meinungsbildung und eine vielfältige, informierte Debatte zu übernehmen.

Zielgruppe: ab Jahrgangsstufe 8

Art des Materials: Videos und Selbstlernmaterial

Link zum Material: Deepfakes und Wahlen

Diese Unterrichtseinheit der Bayerischen Landeszentrale für politische Bildungsarbeit vermittelt, wie Deepfakes entstehen, wo sie missbraucht werden können, wie sie entlarvt werden – und ab wann ihre Nutzung problematisch wird.

Zielgruppe: Jahrgangsstufe 6 - 11

Art des Materials: Video und Selbstlernmaterial

Link zum Material: Deepfakes gegen Fakten

Das Unterrichtsmaterial der Reihe So geht Medien führt Schülerinnen und Schüler an das Thema Deepfakes heran. Sie lernen verschiedene Darstellungsformen kennen, analysieren deren Aufbau und Entstehung, reflektieren ihre Wirkung und setzen sich mit den technischen sowie gestalterischen Bedingungen ihrer Produktion auseinander.

Zielgruppe: Jahrgangsstufe 6 - 11

Art des Materials: Video und Selbstlernmaterial

Link zum Material: Deepfakes - Wie Videos gefälscht werden

Das interaktive Planspiel von Klickwinkel versetzt die Lernenden in verschiedene Rollen – etwa als Betroffene, Journalistinnen und Journalisten – und führt sie durch realitätsnahe Szenarien. Dabei setzen sie sich aktiv mit den Entstehungsmechanismen, Verbreitungswegen und gesellschaftlichen Auswirkungen von Deepfakes auseinander und stärken so ihre Medienkompetenz und ihr kritisches Urteilsvermögen.

Zielgruppe: ab Jahrgangsstufe 7

Art des Materials: Planspiel

Link zum Material: Deepfakes: Was ist noch echt?

Das interaktive „Quiz zum Thema Deepfakes“ von klicksafe und ZDF logo! vermittelt spielerisch Faktenwissen über manipulierte Medieninhalte. Es fördert die Medienkompetenz, indem es Fragen zur Erkennung und dem Umgang mit Deepfakes behandelt und ist sowohl online als auch offline im Unterricht einsetzbar. Passend dazu gibt es noch ein Plakat „Achtung Deepfakes!”.

Zielgruppe: Jahrgangsstufe 5 - 7

Art des Materials: Selbstlernmaterial

Link zum Material: Quiz zum Thema Deepfakes

Das Quiz „Deepfake Detectives“ von klicksafe hilft Jugendlichen dabei, zwischen echten und KI-generierten Inhalten zu unterscheiden. Es ist Teil des Bildungsangebots „Deep Fake – Deep Impact“ und fördert die kritische Auseinandersetzung mit Deepfakes und deren möglichen Auswirkungen.

Zielgruppe: ab Jahrgangsstufe 7

Art des Materials: Selbstlernmaterial

Link zum Material: Quiz „Deepfakes Detectives”

Das Bildungsangebot „Deep Fake – Deep Impact“ von klicksafe richtet sich an pädagogische Fachkräfte und bietet umfassendes Material, um Schülerinnen und Schüler für die Chancen und Risiken von Deepfakes zu sensibilisieren. Es enthält drei praxisnahe Projektideen, die kritisches Denken, Medienkompetenz und kreativen Umgang mit KI-generierten Inhalten fördern.

Zielgruppe: ab Jahrgangsstufe 7

Art des Materials: Lehrmaterial mit Hintergrundwissen und Projektideen

Link zum Material: Deep Fake - Deep Impact

Das Angebot des WDR ist Teil eines Materialpakets zur Vermittlung journalistischer Kompetenzen. „Deepfakes” sind hier der Untersuchungsgegenstand, anhand dessen die Schülerinnen und Schüler lernen, zu recherchieren, Fakten zu finden und Fälschungen aufzudecken. Auch lernen sie, ihre eigene Reportage zu planen. Neben Info-Videos liefert das Material auch Hintergrundinformationen und Arbeitsblätter.

Zielgruppe: ab Jahrgangsstufe 6

Art des Materials: Selbstlernmaterial

Link zum Material: Recherche: Fakten finden und Fakes enttarnen

Die fünfteilige Video-Reihe „Expert*innen-Talk mit Dr. Bernd Zywietz“ von klicksafe bietet fundierte Einblicke in das Thema Deepfakes und deren gesellschaftliche Auswirkungen.

Überblick über die Inhalte:

1 - Was sind Deepfakes?

2 - Wie können Deepfakes von extremistischen Gruppen eingesetzt werden?

3 - Welche Wirkung können Deepfakes haben (beispielsweise vor Wahlen)?

4 - Wie können Jugendliche mit extremistischen Deepfakes in Kontakt kommen?

5 - Wie können wir mit Deepfakes umgehen?

Zielgruppe: ab Jahrgangsstufe 9

Art des Materials: Videos mit Expertinnen- und Experten-Interview

Link zum Material: Was sind Deepfakes?

Das Unterrichtsmaterial „Deepfakes auf der Spur“ bietet Lehrkräften einen klar strukturierten Leitfaden mit didaktischen Hinweisen und Arbeitsblättern, um Jugendliche kreativ an das Thema Deepfakes heranzuführen. Dabei entwickeln die Lernenden in Kleingruppen eigene TV-Serienideen und setzen sich kritisch mit Entstehung, Wirkung und Erkennung von Deepfakes auseinander.

Zielgruppe: ab Jahrgangsstufe 8

Art des Materials: Unterrichtskonzept zur Erarbeitung einer eigenen Serienidee

Link zum Material: Deepfakes auf der Spur

Täuschungen durch Deepfakes - erklärt in 60 Sekunden von KI.NRW

Zielgruppe: Jahrgangsstufe 7 - 13

Art des Materials: Erklärvideo

Link zum Material: (KINRW, 2025): Deep Fakes: Täuschung durch KI erklärt

Wie können KI-generierte Medieninhalte die Meinungsfreiheit und Demokratie gefährden? Wie kann man Fake News erkennen? Welche positiven Auswirkungen kann KI auf Demokratie und Meinungsfreiheit aber auch haben? Und was sagt das KI EU-Gesetz dazu? Diese Verfassungsviertelstunde behandelt ausgehend von Art. 5 GG Herausforderungen und Chancen durch KI.

Zielgruppe: ab Jahrgangstufe 9

Art des Materials: Präsentation mit Kommentaren für die Lehrkraft

Material (ISB):

Kurze Informationen und Hinweise für den Unterricht

Der Verkehr wird in Zukunft zunehmen. Im Unterricht sollte diskutiert werden, ob autonome Fahrzeuge eine mögliche Lösung darstellen.

Woher haben Chatbots ihr Können und was bedeutet das für uns?

KI verändert unser Leben rasant und tiefgreifend. Aber kann KI das Leben auf unserem Planeten nachhaltig verbessern?

Adversarial Attacks sind faszinierend und beunruhigend zugleich. Durch gezielt manipulierte Eingaben, sogenannte Adversarial Examples, lassen sich Schwachstellen in maschinellen Lernmodellen ausnutzen, um die KI in die Irre zu führen.

Welche Folgen kann der Einsatz von KI für uns alle haben? Welche Chancen, aber auch Risiken ergeben sich damit und wie wollen wir damit umgehen?