KI | Neuronale Netze

Kurze Informationen und Hinweise für den Unterricht

Was passiert, wenn eine Superintelligenz unsere Aufgaben genauso gut oder besser erledigt oder wir nicht mehr erkennen können, ob wir es mit einem Roboter oder einem Menschen zu tun haben? In diesem Beitrag sollen Visionen und Realitäten einer starken KI gegenübergestellt werden.

Faszination und Furcht vor einer bedrohlichen Zukunft

Künstliche Intelligenzen, wie sie in Science-Fiction-Darstellungen präsentiert werden, besitzen oft ein Bewusstsein und die Fähigkeit zur Selbstreflexion. Im Film „Matrix” übernehmen sie die Kontrolle über die Menschheit und versklaven diese: Ursprünglich von den Menschen geschaffen, hat sich in der Welt der Matrix eine künstliche Intelligenz gegen ihre Schöpfer gewandt. Sie lässt die Menschen in einer Computersimulation leben, während sie selbst als menschliche Energiespender dienen. Der Film „2001: Odyssee im Weltraum” handelt von dem vorerst unfehlbaren Computer HAL 9000, der ein Eigenleben entwickelt und zu einer existentiellen Bedrohung wird.

In 'Blade Runner' wiederum werden künstliche Intelligenzen, die sogenannten Replikanten, in die Gesellschaft integriert. Diese künstlichen Menschen haben eine begrenzte Lebensdauer von vier Jahren, was als Schutzmaßnahme gegen mögliche Bedrohungen dient.

Science-Fiction-Erzählungen reflektieren ambivalente menschliche Beziehungen zu superintelligenten Maschinen – von möglichen Lebensverbesserungen bis hin zu existenziellen Bedrohungen. Doch in der Realität ist eine Superintelligenz, eine Maschine, die dem Menschen in allen Bereichen überlegen ist, bisher noch nicht greifbar.

Die potenziellen Auswirkungen fortschreitender Technologie werden in fiktiven Darstellungen wie in Science-Fiction-Literatur und Filmen deutlich. Bislang sind diese Darstellungen jedoch nur ein Spiegel der aktuellen gesellschaftlichen Ängste, Hoffnungen und ethischen Überlegungen.

Der Begriff Superintelligenz stammt meist aus der Science-Fiction, während die Forschung von einer starken KI spricht - einer „Software die menschliche Fähigkeiten in fast allen Punkten erreicht oder gar übersteigt“ (Zweig, 2019, S. 318). Im Gegensatz dazu bezeichnet man eine schwache KI als Software, die eine "bisher für spezifisch menschlich gehaltene kognitive Einzelfähigkeit ersetzen kann“ (Zweig, 2019, S. 318), wie zum Beispiel Bilder erkennen, Texte übersetzen oder Vorhersagen berechnen.

Nicht nur Science-Fiction-Autoren, deren Ideen oft in den 1960er Jahren - der Geburtszeit der künstlichen Intelligenz - ihren Ursprung haben, verbreiten Ängste vor einer Superintelligenz als neuer Lebensform. Auch Wissenschaftlerinnen und Wissenschaftler und Philosophinnen und Philosophen beschreiben drastische Auswirkungen einer starken KI.

Der Astrophysiker Stephen Hawking warnte 2017 vor einer KI, die sich optimiert und repliziert und so eine neue Lebensform wird, die die Leistung der Menschen übertrifft (Rötzer, 2017). Elon Musk verglich das Eintreten einer Superintelligenz mit einer Kernschmelze und empfahl, den Fokus der KI-Forschung auf KI-Sicherheit zu legen (Muehlhauser, 2015). Der Philosoph Nick Bostrom sieht in der Superintelligenz eine mögliche existentielle Bedrohung für die Menschheit und die Auswahl eines übergeordneten Ziels, wie Freundlichkeit zu oder Freundschaft mit dem Menschen sei von zentraler Bedeutung (Bostrom, 2003).

Künstliche Intelligenz wird immer leistungsfähiger. Die Vorstellung einer technologischen Singularität, d.h. eines Zeitpunktes, an dem Maschinen menschliche Fähigkeiten erreichen oder sogar übertreffen, weckt sowohl Faszination als auch Besorgnis. Die Prognosen darüber, wann dieser Wendepunkt erreicht ist, variieren erheblich.

Vernor Vinge, ein renommierter Mathematiker, setzte bereits 1993 den Zeitpunkt der Singularität auf dreißig Jahre später an. Er betonte, dass eine Voraussetzung dafür eine Verbesserung der Hardware einschließlich Rechenleistung, Netzwerken und Mensch-Maschine-Schnittstellen sowie die Bereitstellung von Nanotechnologien seien. Dabei unterstrich er die Notwendigkeit, Vorsichtsmaßnahmen zu treffen, um sicherzustellen, dass eine entstehende Superintelligenz der Menschheit wohlgesonnen ist (Vinge, 1993).

Raymond Kurzweil, Computerpionier und Transhumanist, wagte im Jahr 2017 eine genauere Prognose: Er setzte den Zeitpunkt der Singularität auf 2045 an. Bereits 2029 sollten nach seinen Berechnungen Computer eine Intelligenz auf menschlichem Niveau erreichen. Kurzweil stützte seine Berechnungen auf das Mooresche Gesetz, das das exponentielle Wachstum der Prozessorgeschwindigkeit beschreibt. Dieses exponentielle Wachstum lässt sich auch in der technologischen Entwicklung der Menschheitsgeschichte erkennen. Er betrachtet die Singularität als Chance für die Menschheit, sich zu verbessern, indem neuronale Implantate das Sehen, Hören und die Gedächtnisleistung verbessern. In naher Zukunft habe seiner Einschätzung nach die Menschheit die Unsterblichkeit erreicht. Mit dem Upload menschlicher Gehirne würden maschinelle Gegenstücke existieren und die Fusion von Mensch und Maschine stattgefunden haben (Kurzweil, 2020).

Trotz dieser optimistischen Visionen gibt es Kritiker wie den ehemaligen Informatik-Professor Joseph Weizenbaum, einen Pionier der künstlichen Intelligenz und Entwickler des Chatbots ELIZA. Weizenbaum betrachtet die verbreitete Überzeugung, die Natur könne durch die Wissenschaft vollständig verstanden und objektiv berechenbar gemacht werden, als eine „katastrophale Fehlentwicklung des menschlichen Denkens” (maschafilm, 2010).

Eine der grundlegenden Fragen ist bislang ungelöst: Wie kann ein künstliches Gehirn, das neuronale Prozesse ähnlich wie ein menschliches Gehirn durchführt, Bewusstsein erlangen? Die Natur des Bewusstseins – wie Verstehen und Selbsterkenntnis – bleibt unerforscht. „Warum fühlt es sich wie etwas an, einen bestimmten Gehirnzustand zu haben (z. B. beim Verspeisen eines Hamburgers), während es sich wahrscheinlich nicht wie etwas anfühlt, andere physische Zustände zu haben (z. B. ein Stein zu sein).“ (Russell, Norvig, 2012, S. 1190)

KI-Forscherinnen und KI-Forscher sind sich über das Wie und Wann des Einsatzes einer starken KI uneinig. Prognosen aus verschiedenen Untersuchungen im Jahr 2022 zeigen, dass viele Expertinnen und Experten eine echte Chance darin sehen, dass künstliche Intelligenz, die der menschlichen Intelligenz ebenbürtig ist, in den nächsten Jahrzehnten entwickelt wird (Roser, 2023).

Jürgen Schmidhuber, ein Informatiker, sieht die Entwicklung zur starken KI als unaufhaltsam an. Er glaubt jedoch nicht daran, dass starke KIs ein Interesse daran hätten die Menschheit zu vernichten. Menschen bringen auch keine Ameisen um, obwohl sie doch viel klüger sind (Schmidhuber, Bieber, Laslo, 2015).

In einem Interview skizziert Schmidhuber grob die Funktionsweise einer starken KI, die zwei lernende Module benötigt: den „Gestalter“ und das „Weltmodell“. Der Gestalter ist ein besonderer Computer, der wie ein Gehirn funktioniert. Er nimmt Informationen auf und entscheidet dann, was zu tun ist. Er kann verschiedene Aufgaben haben, wie zum Beispiel Schach spielen oder als Roboter zu einer Ladestation fahren. Um ihm zu helfen, gut zu arbeiten, beschreibt Schmidhuber etwas, das man Belohnungsfunktion nennt. Das ist wie ein Punktesystem: wenn der Gestalter sein Ziel erreicht, wie beim Gewinnen eines Schachspiels, bekommt er Punkte. Er versucht dann, so viele Punkte wie möglich zu sammeln.

Der Gestalter hat auch ein Weltmodell. Das ist wie eine Karte in seinem Kopf, die ihm hilft vorauszusagen, was passieren wird, wenn er etwas tut. Er benutzt diese Karte, um zu planen und gute Ergebnisse zu erreichen. Außerdem lernt der Gestalter neugierig dazu, indem er Experimente macht, die ihm helfen, seine Karte zu verbessern. Das ist ähnlich wie ein Wissenschaftler, der neue Dinge lernt und sich freut, wenn er etwas Neues versteht (Schmidhuber, Bieber, Laslo, 2015).

In der Entwicklung künstlicher Intelligenz spielen die festgelegten Optimierungsziele eine entscheidende Rolle. Jürgen Schmidhuber gibt dem Gestalter und dem Weltmodell klare Ziele durch eine Formulierungsfunktion vor. Problematisch ist, dass das Erreichen eines Ziels verheerende Nebenwirkungen haben kann, wie das Beispiel des Büroklammer-Maximizers von Bostrom zeigt. Bostrom beschreibt eine KI mit dem Ziel, möglichst viele Büroklammern zu produzieren. Um die Ressourcen zu beschaffen und bereitzustellen, würde die KI schnell feststellen, dass Menschen dabei im Weg stehen, und entscheiden diese auszuschalten (Bostrom, 2003).

Der Philosoph Thomas Metzing wirft die Frage auf, wie eine KI, die das Beste für alle Menschen im Sinn hat, ihre Ziele verfolgen würde. Hier zeigt sich ein ethisches Dilemma: Angesichts der Tatsache, dass Leid im menschlichen Leben häufiger vorkommt als Glück, könnte eine künstliche Intelligenz zu dem Schluss kommen, dass die Menschheit langsam aussterben muss, um sie vom Leid zu befreien (Metzinger, 2017).

Katharina Zweig veranschaulicht problematische Optimierungsfunktionen anhand von Algorithmen auf Plattformen wie YouTube. Diese empfehlen Videos voller Fake News und Verschwörungstheorien, um die Aufmerksamkeit der Zuschauer zu maximieren. Sie betont, dass „gut gemeinte, aber nicht vollständig durchdachte oder einseitig formulierte Optimierungsfunktionen in den ersten Anläufen oftmals gravierende Nebenwirkungen haben. Aber wenn es eine starke KI geben soll, kommen wir um eine <<Master Optimierungsfunktion>> nicht herum“ (Zweig, 2019, S. 273). Zweig zieht einen Vergleich zum menschlichen Gehirn: „Bei uns Menschen ist diese Optimierungsfunktion verdrahtet in unseren Neuronen, verankert im Körper und wird gesteuert durch Hormonausschüttungen und Nervensignale. Es ist fraglich, ob diese komplexe Funktion, die zudem individuell ist und sich dynamisch verändert, wirklich gelernt werden könnte“ (Zweig, 2019, S. 310).

Von wem darf die KI also lernen? Es stellt sich die Frage nach einer sinnvollen Auswahl von Daten und sozialen Konzepten, mit denen diese Optimierungsfunktion erstellt wird, denn in verschiedenen Kulturen werden Probleme unterschiedlich bewertet und entschieden.

Zweig schließt daraus, dass „nur zwei Dinge die Idee einer starken menschenzentrierten KI noch retten. Erstens, wenn fast alle sinnvoll aussehenden Optimierungsfunktionen nur kleine Nebenwirkungen erwarten lassen. Oder zweitens, wenn wir schnell eingreifen könnten, falls etwas schief geht.“ Die Nebenwirkungen einer neuen Technologie zeigen sich allerdings erst bei der Anwendung und sind dann nicht mehr zu stoppen. Ein Beispiel dafür ist der Verbrennungsmotor, der erst durch die immense Zahl der Autofahrer zum Umweltproblem wurde (Zweig, 2019).

Angesichts des hohen Risikos negativer Auswirkungen einer starken KI sieht Zweig daher keinen Nutzen für diese und empfiehlt, die Forschung auf schwache KI zu beschränken (Zweig, 2019).

Von Asimov bis zu aktuellen Regulierungen

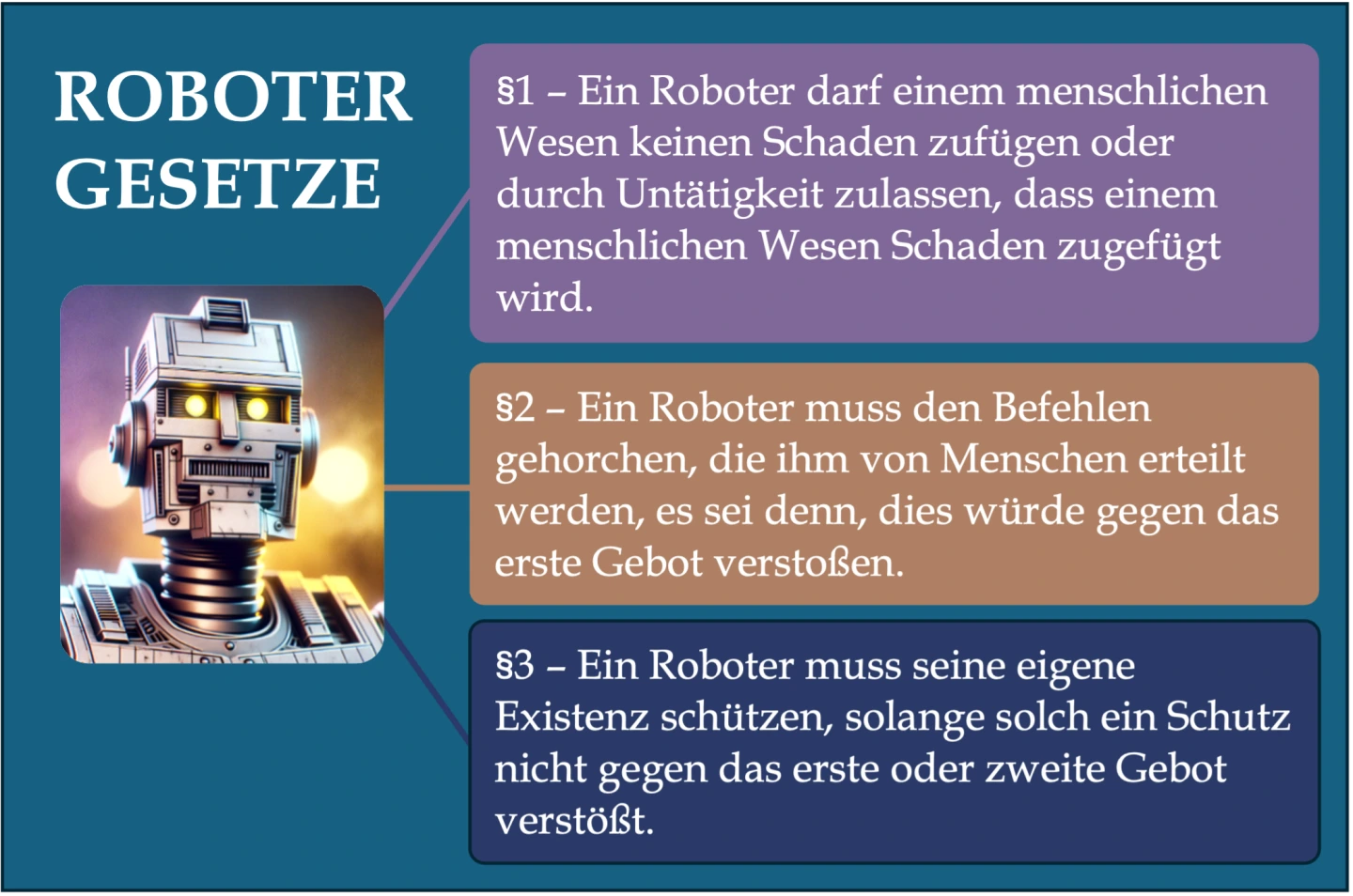

Schon im Jahr 1942 formulierte der Science Fiction Autor Isaac Asimov die berühmten Robotergesetze, die den Robotern eine moralische Richtlinie vorgeben:

Allerdings zeigt sich, dass die Umsetzung dieser scheinbar vernünftigen Gesetze schwierig ist, da sie sich gegenseitig widersprechen können. „Ein Roboter mag die Ungerechtigkeit bemerken, dass es einem Menschen erlaubt wird, einen anderen in Notwehr zu töten, doch von einem Roboter wird verlangt, sein eigenes Leben zu opfern, um einen Menschen zu retten.“ (Russel, Norvig, 2012, S. 1197)

Im Jahr 2020 forderte die europäische Kommission im „WEISSBUCH Zur Künstlichen Intelligenz" einen Regulierungsrahmen mit Raum für eine vertrauenswürdige KI. Trotzdem sind bisher nur in einigen wenigen Ländern Ansätze zur Zertifizierung von KIs vorhanden.

Die Herausforderung besteht darin, ethische Grundsätze für einen verantwortungsbewussten Umgang mit KI zu definieren und sicherzustellen, dass sie in der Praxis umsetzbar sind.

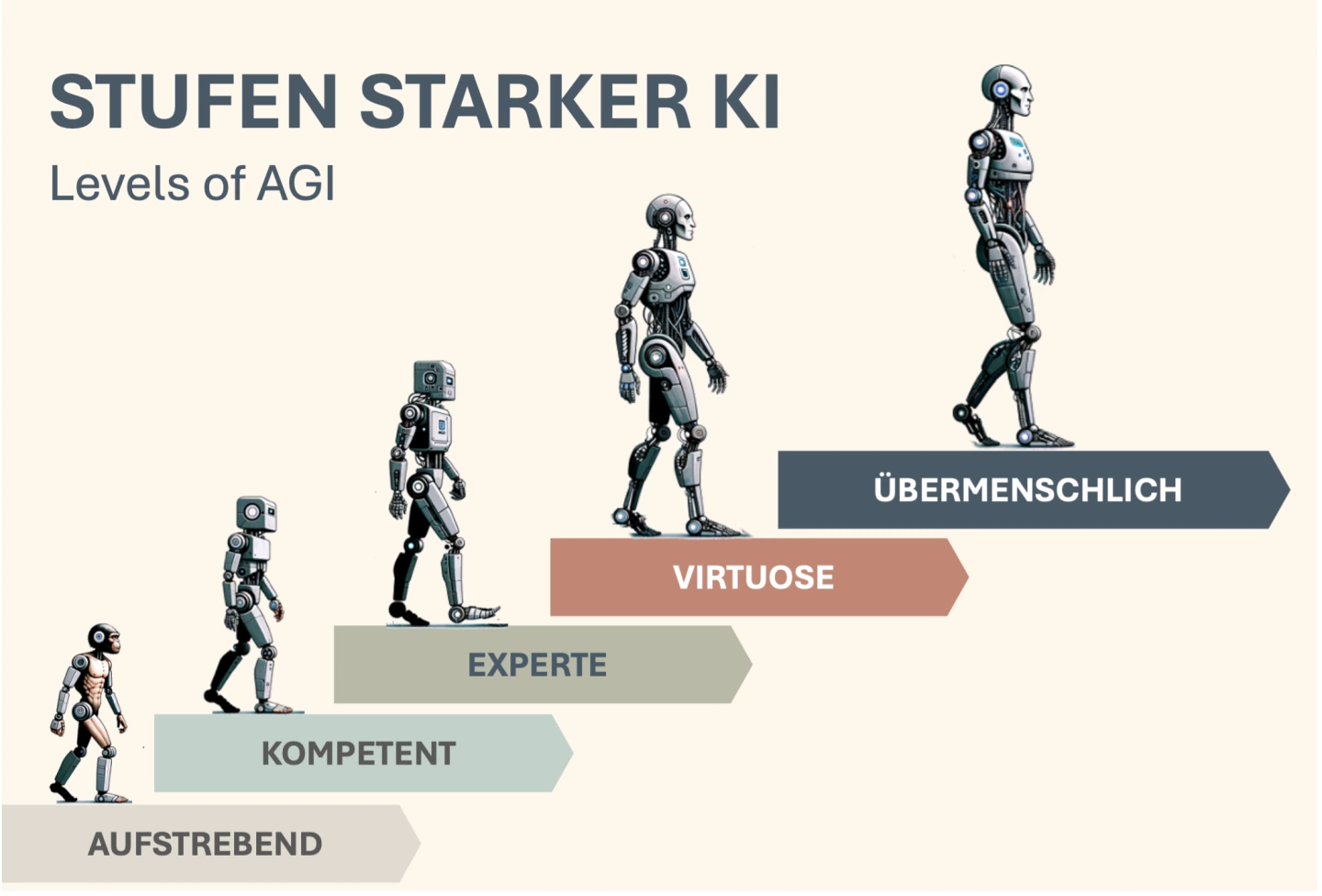

Im Jahr 2023 veröffentlichte ein Team von Google Deep Mind die ‚Levels of AGI‘, ein fünfstufiges System zur Klassifizierung von KI-Systemen. Der Begriff AGI steht für, Artificial General Intelligence‘ und bezieht sich auf künstliche Intelligenz, die menschenähnlich agiert oder den Menschen sogar übertrifft.

Bislang ist nur die Stufe 1 erreicht, das sogenannte ‚Aufstrebend‘. Dies bedeutet, dass KI-Modelle wie ChatGPT von OpenAI, Bard von Google oder Llama 2 von Meta auf dem Niveau eines ungelernten Mensch agieren oder sogar etwas besser sind.

Die weiteren Stufen werden wie folgt beschrieben:

Stufe 2 ‚Kompetent‘: KIs sind so intelligent wie die Hälfte der gebildeten Erwachsenen.

Stufe 3 ‚Experte‘: KIs sind so intelligent wie 90% der gebildeten Erwachsenen.

Stufe 4 ‚Virtuose‘: KIs sind so intelligent wie 99% der gebildeten Erwachsenen.

Stufe 5 ‚Übermenschlich‘: Dies bezeichnet Superintelligenzen, „die eine breite Palette von Aufgaben besser als alle Menschen erledigen, einschließlich Aufgaben, die Menschen überhaupt nicht erledigen können, wie das Dekodieren der Gedanken anderer Menschen, die Vorhersage zukünftiger Ereignisse und das Sprechen mit Tieren“ (Heaven, 2023).

Im Bereich der schwachen KI gibt es genauso eine Einteilung in fünf Stufen, die das Erreichen eines begrenzten Aufgabengebiets beschreiben. Alle diese fünf Stufen wurden bereits erreicht. Ein Beispiel dafür ist Alpha Fold, eine KI, die das Proteinstrukturen aus Aminosäuresequenzen vorhersagen kann. Diese Aufgabe konnte bisher kein Mensch bewältigen. Daher wird Alpha Fold als Stufe 5 eingestuft, was übermenschlicher schwacher KI entspricht (Morris, Sohl-dickstein, Fiedel, Warkentin, Dafoe, Faust, Farabet, Legg, 2024).

Kurze Informationen und Hinweise für den Unterricht

KI verändert unser Leben rasant und tiefgreifend. Aber kann KI das Leben auf unserem Planeten nachhaltig verbessern?

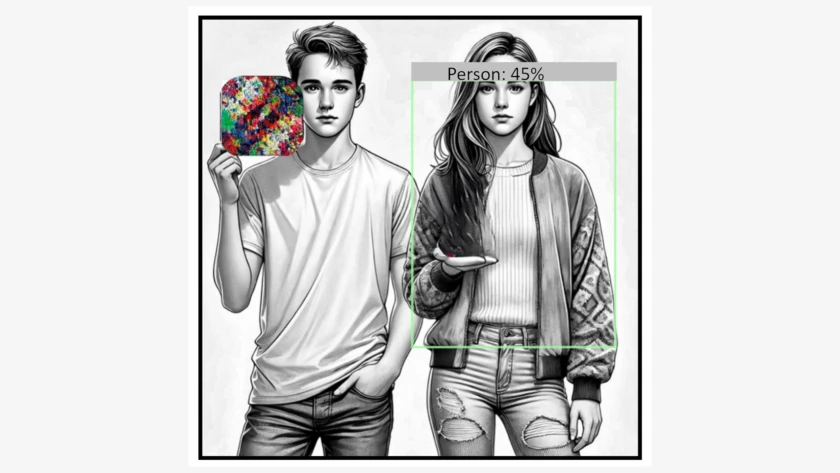

Angesichts der Verbreitung von KI stellt sich die kritische Frage nach der Datenzuverlässigkeit und wie Verzerrungen entstehen: Welche Auswirkungen hat dies auf Diskriminierung?

Wieso sollten sich Schülerinnen und Schüler mit Künstlicher Intelligenz befassen? Auf welche Informationen können Sie als Lehrkraft zurück greifen?

Adversarial Attacks sind faszinierend und beunruhigend zugleich. Durch gezielt manipulierte Eingaben, sogenannte Adversarial Examples, lassen sich Schwachstellen in maschinellen Lernmodellen ausnutzen, um die KI in die Irre zu führen.

Wenn Maschinen Augen bekommen: Erfahren Sie in diesem Artikel mehr darüber, wie Bilderkennungstechnologien unser tägliches Leben beeinflussen und welche Auswirkungen dies auf unsere Zukunft haben könnte.