KI | Die Geschichte der Künstlichen Intelligenz

Lesen Sie hier, welche wichtigen Meilensteine aber auch Rückschläge die KI im Laufe der letzten Jahrzehnte erfahren hat.

„Sag Hi zu My AI” - damit begrüßt der virtuelle Freund My AI in einem bekannten Instant-Messaging-Dienst seine Nutzerinnen und Nutzer und ist fortan in der Liste der Chats verfügbar. Aktuell lässt er sich nur in der kostenpflichtigen Version entfernen oder zumindest von Platz 1 der Freundesliste verdrängen.

Mal schnell etwas fragen, was man sonst niemand fragen will, weil es peinlich ist? Oder wie ich die Mathe-Hausaufgabe löse? Oder einfach eine lustige Unterhaltung führen? My AI ist immer verfügbar, antwortet freundlich, ist manchmal hilfreich, manchmal unterhaltsam, warum also nicht?

My AI ist ein Beispiel der vielen, leicht verfügbaren Anwendungen, die ChatGPT oder andere mächtige Textgeneratoren integrieren und mit denen Kinder und Jugendliche im Alltag kommunizieren.

Schulen stehen vor der Herausforderung, den Umgang mit diesen Technologien pädagogisch sinnvoll zu integrieren und zu begleiten. Lesen Sie hier, was hinter den aktuellen Chatbots steckt und wie sie funktionieren, welche Chancen sich damit eröffnen und was beim Einsatz zu beachten ist.

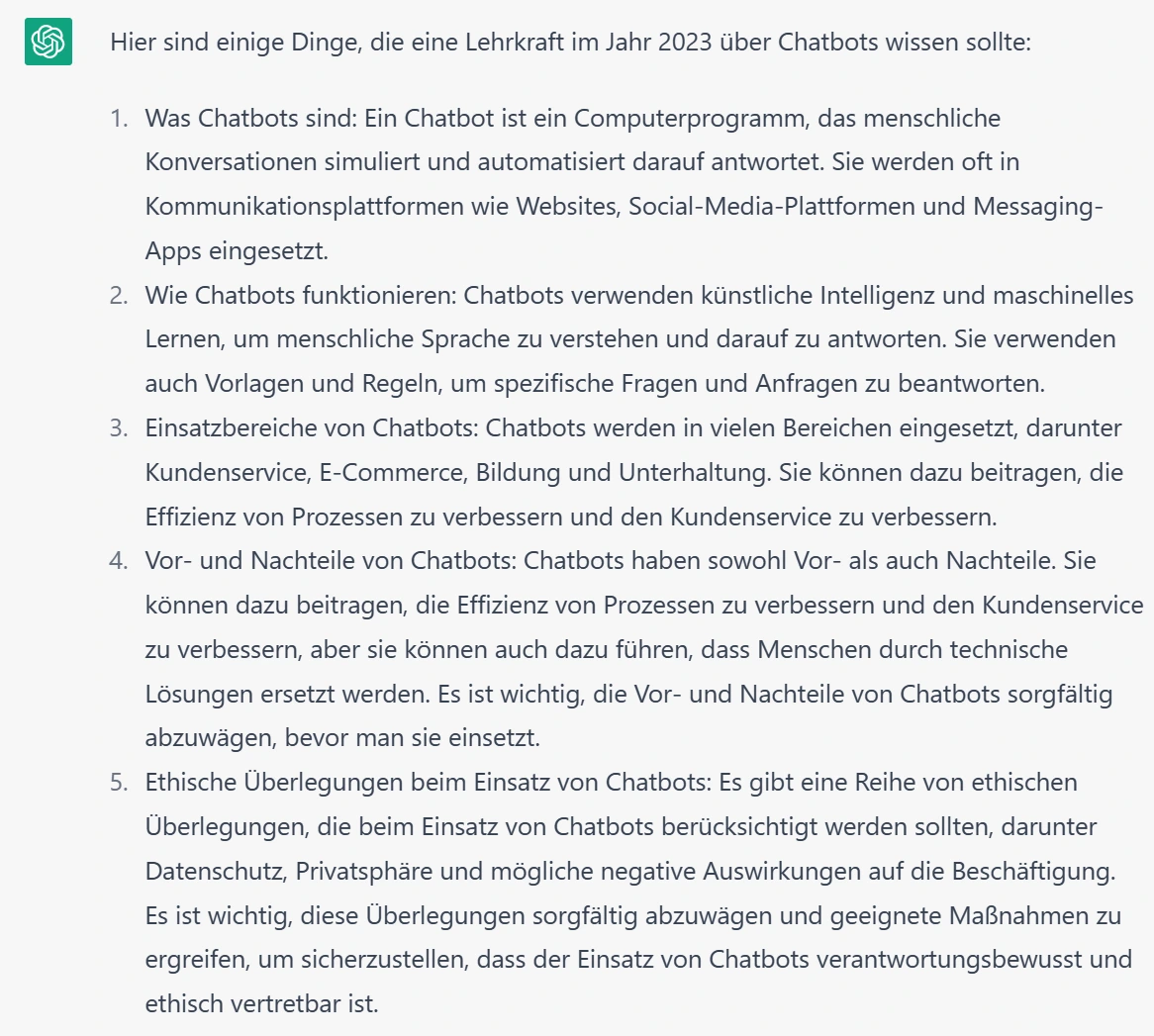

Am 9. Januar 2023 antwortete ChatGPT auf die Frage: „Was sollte jede Lehrkraft im Jahr 2023 über das Thema Chatbot wissen?”

Unabhängig davon wie sinnvoll Sie diese Antworten finden, zeigen sie zumindest auf den ersten Blick für einen Chatbot erstaunliche Formulierungsfähigkeiten und bemerkenswertes Allgemeinwissen.

Ein Chatbot wird darin beschrieben als „Computerprogramm, das menschliche Konversationen simuliert und automatisiert darauf antwortet.” Dies ist inhaltlich korrekt. Allerdings gibt es bereits bei den genannten Einsatzbereichen Websites, Social-Media-Plattformen und Messaging-Apps einiges hinzuzufügen. Auch die weiteren Punkte werden inhaltlich knapp, aber oberflächlich behandelt.

Falls Sie also genauer, konkreter und von menschlicher Intelligenz beantwortet haben wollen, was Sie als Lehrkraft wissen sollten, lesen Sie hier weiter.

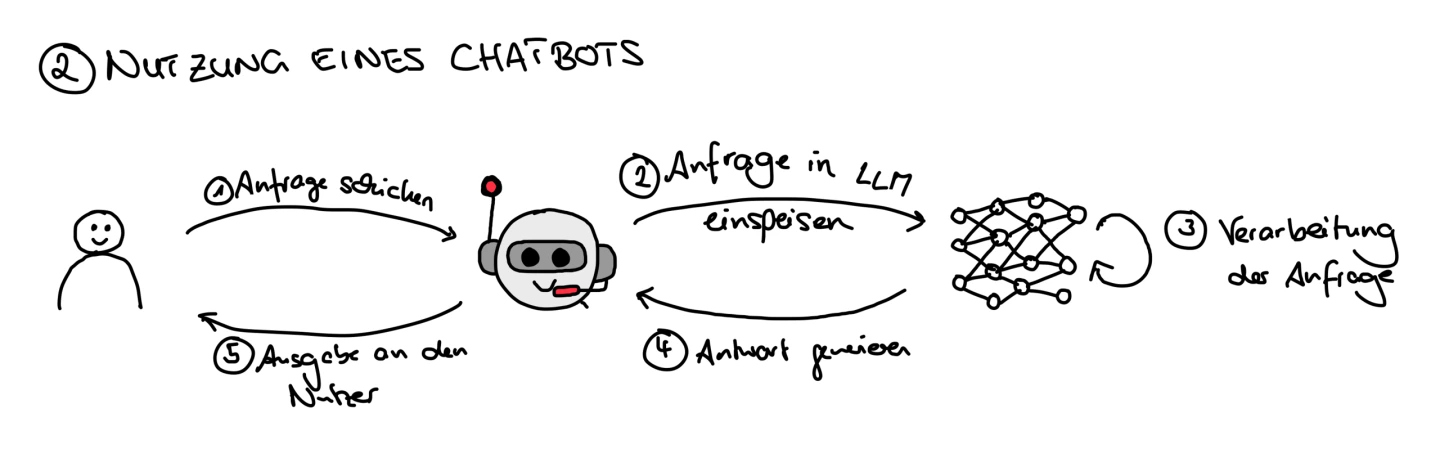

ChatGPT beschreibt die Funktionsweise von Chatbots so: „Chatbots verwenden künstliche Intelligenz und maschinelles Lernen, um menschliche Sprache zu verstehen und darauf zu antworten. Sie verwenden auch Vorlagen und Regeln, um spezifische Fragen und Anfragen zu beantworten.“ Diese Beschreibung ist größtenteils korrekt, zu bemängeln wäre lediglich, dass in dieser Formulierung nicht deutlich wird, dass maschinelles Lernen ein Teilbereich der Künstlichen Intelligenz ist. Im Folgenden soll seine Aussage vertieft und an Beispielen verdeutlicht werden.

Die einfachsten Chatbots verfügen über ein Vorwissen aus „Vorlagen und Regeln” und wenden diese an, um eine Unterhaltung zu führen.

Seit den 1960er Jahren, in denen Chatbots zunächst noch Gegenstand der Forschung waren, werden Chatbots eingesetzt, um die Anfragen von Menschen entgegenzunehmen und diese basierend auf ihrem Vorwissen zu beantworten. Um dies zu realisieren, verfügen die einfachsten Chatbots über „Vorlagen und Regeln”, die sie anwenden, um eine Unterhaltung zu führen. Eine solche Regel könnte lauten, dass der Chatbot auf jede Eingabe von „Hallo” mit „Mein Name ist Bot, wie kann ich helfen?” antwortet (mehr dazu weiter unten im Abschnitt über AIML).

Die weitere Entwicklung der Computer und die Möglichkeiten der Vernetzung ließen auch die Fähigkeiten der Chatbots wachsen. So folgten ab den 1990er Jahren Chatbots, die geeignet waren zum Einsatz auf Webseiten, mit der Möglichkeit sich an vorher Gesagtes zu „erinnern“ und mit einer immensen Basis von „angelesenem“ Wissen aus Milliarden von Texten, z. B. eBooks oder Wikipedia-Seiten. Gemeinsam ist all diesen Chatbots, dass sie regelbasiert sind, d. h. ihre Antworten folgen von Menschen festgelegten Regeln und sind – bei Kenntnis dieser Regeln - vorhersagbar und damit kontrollierbar.

Im Folgenden finden Sie einen Überblick über die Meilensteine bei der Entwicklung regelbasierter Chatbots.

Den ersten Chatbot entwickelte 1966 der deutsch-amerikanische Informatiker Joseph Weizenbaum (1923-2008) zu Forschungszwecken. Mit ELIZA wollte er untersuchen, wie gut Kommunikation zwischen Mensch und Computer in natürlicher Sprache funktionieren kann. Diese Forschung, die sich mit der maschinellen Verarbeitung natürlicher Sprachen beschäftigt, wird heute als Computerlinguistik bezeichnet.

Der Chatbot wurde dabei so gestaltet, dass er eine bestimmte Art von Psychotherapeut simulieren sollte, der so antworten durfte, als wisse er nichts über die reale Welt. So konnte ELIZA z. B. auf die menschliche Feststellung „Ich habe eine lange Bootsfahrt gemacht“ mit „Erzählen Sie mir über Boote“ antworten konnte, ohne die Unterhaltung unglaubwürdig wirken zu lassen.

Weizenbaum war vor allem überrascht, wie leicht sich Menschen täuschen ließen, er berichtet: „Some subjects have been very hard to convince that ELIZA (with its present script) is not human“ (Weizenbaum, 1966, S. 42). (Nebenbei: Weizenbaum sah die Entwicklung des Umgangs mit Computern und seine gesellschaftlichen Auswirkungen zunehmend kritisch und bezeichnete sich selbst als „Ketzer der Informatik“, der stets für eine bewusste Auseinandersetzung mit dieser Technologie eintrat statt sie kritiklos anzuwenden.)

Erleben Sie ELIZA selbst:

Können Sie ELIZA dazu bringen, sich als Maschine zu outen? Kann eine Unterhaltung mit ELIZA hilfreich sein?

Um zu messen, wie gut ein Chatbot menschliche Kommunikation simulieren kann, kann man die Zeit betrachten, die ein Mensch braucht um festzustellen, ob es sich beim Kommunikationspartner um eine Maschine oder einen Menschen handelt.

Die Idee für diesen „Turing-Test“ geht auf eine Idee des britischen Informatikers Alan Turing (1912-1954) zurück, der 1950 auf der Suche nach einer Antwort auf die theoretische Frage „Können Maschinen denken“ ein von ihm so genanntes „Imitation Game“ entwarf, bei dem ein Mensch herausfinden sollte, ob er gerade mit einer Maschine oder einem Menschen kommunizierte (Turing, 1950).

Zu bedenken ist aber auch, was der deutsche Autor Marc-Uwe Kling in Qualityland einen seiner Protagonisten zitieren lässt: „›Jede Maschine, die schlau genug ist, den Turing-Test zu bestehen, könnte auch schlau genug sein, ihn nicht zu bestehen.‹“ (Kling, 2019, S. 185)

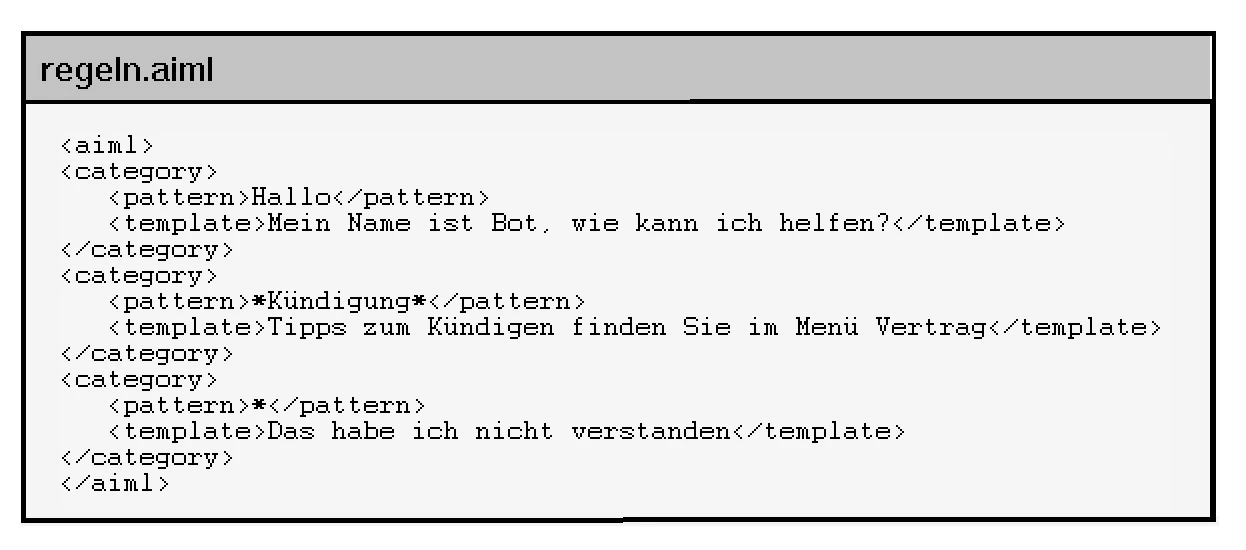

Für die ersten Chatbots standen wenige digitale Texte als Lernmaterial und wenig Rechenpower zum „Lernen“ zur Verfügung. Trotzdem konnten sie bereits beachtlich chatten, da Menschen ihnen Regeln beigebracht hatten. Ende der 90er Jahre hatte Richard Wallace die Skriptsprache AIML (Artificial Intelligence Markup Language) entwickelt, um solche Regeln zu formulieren, und nützte diese Sprache für seinen Chatbot ALICE (für Artificial Linguistic Internet Computer Entity).

In dieser Sprache können Regeln formuliert werden, in denen festgelegt wird, mit welcher Ausgabe („template”) der Chatbot auf eine Eingabe („pattern”) reagiert. Beispielsweise soll der Chatbot jede Eingabe von „Hallo” mit „Mein Name ist Bot, wie kann ich helfen?” antworten. Enthält eine Eingabe das Wort „Kündigung“, dann antwortet der Chatbot mit dem Hinweis auf die passende Webseite. Gibt der Nutzer einen unbekannten Text ein, dann antwortet der Chatbot mit „Das habe ich nicht verstanden”. Bei Kenntnis dieser Regeln sind die Antworten dieser Chatbots also vorhersagbar und kontrollierbar.

Da sowohl AIML als auch der Programm-Code für einen solchen Chatbot als Werkzeugkästen öffentlich zugänglich sind, wurden seitdem unzählige solche kontrollierbare Chatbots erstellt und unterstützen Menschen z. B. auf Webseiten bei Behördengängen und Einkäufen.

Erleben Sie ALICE selbst:

Wer ALICE ausprobiert, wird feststellen, dass sie beachtlich kommunizieren kann. Allerdings hat sie auch deutliche Schwächen, zum Beispiel wechselt sie bei Fragen, die sie nicht beantworten kann, einfach das Thema (was Menschen nie tun würden 😉).

Können Sie ALICE dazu bringen, sich als Maschine zu outen? Kann eine Unterhaltung mit ALICE hilfreich sein? Vergleichen Sie ihr Verhalten auch mit dem von ELIZA.

Mehr über die Entwicklung des Forschungsbereichs finden Sie hier im Magazin im Artikel Geschichte der künstlichen Intelligenz.

Die aktuell Aufsehen erregenden Chatbots wie ChatGPT, Bard, LaMDA, LLaMa oder Luminous sind so mächtig weil sie – vereinfacht gesagt - nicht nur mit von Menschen formulierten Regeln ausgestattet wurden, sondern auch menschliches Lernen nachahmen können, indem sie Techniken des maschinellen Lernens anwenden.

Bevor diese Chatbots genutzt werden können, bauen sie in einer Trainingsphase ihren Sprachschatz auf, indem sie Milliarden von digitalen Texten z. B. auf Websites, in Foren oder eBooks hinsichtlich Wortschatz und Struktur analysieren und das erworbene Wissen in einem großen Sprachmodell - einem Large Language Model (LLM) - speichern.

Dazu muss das Gelesene – genauer genommen die in den Texten enthaltenen sprachlichen Strukturen - zunächst in eine für einen Computer verständliche Form gebracht werden. Mit diesem Teilgebiet der Informatik beschäftigt sich die Computerlinguistik bzw. ihr Teilgebiet Natural Language Processing (NLP). NLP beschreibt Strukturen und Methoden, mit denen die Grammatik und Syntax einer Sprache gespeichert („codiert“) werden können.

Mit den Techniken des NLP kann man den Bedeutungszusammenhang von Wörtern mit Hilfe von räumlichen Vektoren darstellen. Dabei liegt die Idee zugrunde, dass es einen Bedeutungsraum gibt, in dem Wörter je nach ihrer Bedeutung positioniert sind. Je mehr sich die Bedeutungsräume zweier Wörter ähneln, desto näher sind diese Wörter im Bedeutungsraum positioniert. So sind die Worte „Mutter“ und „Vater“ im Bedeutungsraum relativ nah zueinander positioniert und verhalten sich zueinander wie „Königin“ zu „König“. Häkeldecke und Motorrad sind jedoch zwei weit voneinander entfernt positionierte Begriffe.

Mehr über die Methoden des Natural Language Processing (NLP) finden Sie z. B. hier:

Sprachliche Vektoren: Die Vermessung des Bedeutungszusammenhangs von Worten

Unter dem folgenden Link finden Sie eine Darstellung so eines Wortraumes. Geben Sie selbst Wörter ein und erforschen Sie deren Position und Zusammenhänge im Wortraum.

Der Chatbot wendet die im LLM gespeicherten Regeln an, um eine Anfrage eines Nutzers mit möglichst wahrscheinlich erscheinenden Wortfolgen zu beantworten. Der Chatbot „plappert” also im Training erlernte Wortfolgen nach oder kombiniert sie neu. Daher wurden solche Chatbots 2021 von einer KI-Forschergruppe auch als „stochastische Papageien” bezeichnet (Bender et al., 2021).

Einführung in Natural Language Processing

Falls Sie neugierig geworden sind und mehr über die Techniken des NLP wissen möchten, finden Sie hier eine allgemeinverständliche Einführung in Natural Language Processing (NLP) von Michael Notter (18 min Lesezeit). (Tipp: Übersetzen Sie den englischsprachigen Artikel ggf. mit einem Übersetzungsprogramm.)

Die eben beschriebenen Techniken des NLP haben illustriert, wie Sprache in eine für den Computer verständliche Form gebracht werden kann. Die angesprochenen sprachlichen Strukturen werden dem Chatbot jedoch nicht als feste „Regeln“ vorgegeben, sondern sie sind in einem künstlichen neuronalen Netz gespeichert, einer Art künstlichem Gehirn, das anhand von Milliarden von Texten lernt, welche Beziehungen konkrete Wörter zueinander haben. Je nachdem an wie vielen und an welchen Texten das neuronale Netz gelernt hat, kann es mehr oder weniger gut formulierte Texte liefern.

Nach dem Training kann der Chatbot also anhand seines im LLM gespeicherten Sprachschatzes menschliche Anfragen beantworten.

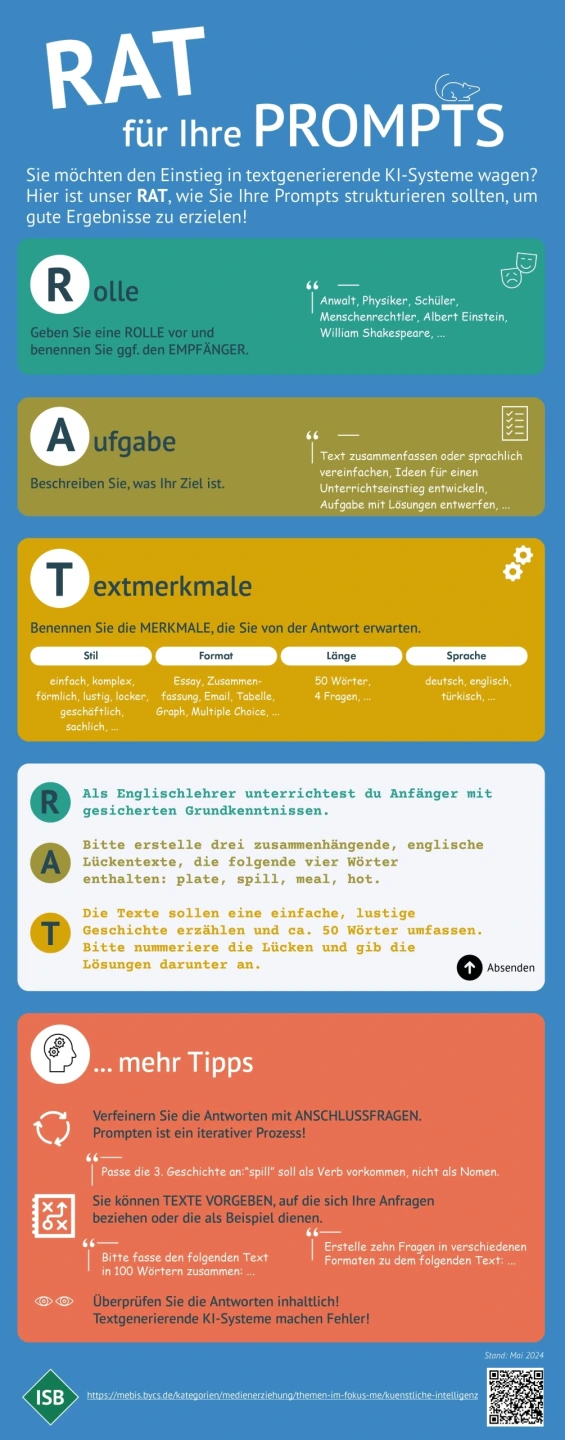

Die Kunst des Promptens: „Prompt Engineering“

Die Antwort des Chatbots hängt ganz wesentlich von der Formulierung der Anfrage des Nutzers, dem sogenannten „Prompt“, ab. Je detaillierter die Angaben zur gewünschten Textart, zum Empfänger und zum Kontext sind, desto passender wird der generierte Text sein, z.B. wird „Schreibe für eine Lehrerfortbildung eine Gliederung für einen 10minütigen Vortrag über Chatbots” ein deutlich anderes Ergebnis liefern wie der Prompt „Was sollte jede Lehrkraft über das Thema Chatbot wissen?”

Die Technik, gute Prompts zu erzeugen, wird als Prompt Engineering bezeichnet.

Mittlerweile hat sich ein Markt von teilweise kommerziellen Prompt-Angeboten und -Diensten zur Optimierung von Prompts entwickelt.

Wichtig bleibt aber in jedem Fall eine kritische Überprüfung des generierten Textes auf sachliche Richtigkeit, z. B. mit Hilfe von Fachliteratur, wissenschaftlichen Datenbanken und last but not least eigenem Wissen (Bager, 2023, S. 26).

Wie das Lernen technisch funktioniert, finden Sie hier im Magazin im Artikel Neuronale Netze erklärt.

Als Ausblick lässt sich festhalten, dass zur Entwicklung eines Large Language Models folgendes nötig ist:

Superrechner oder sehr viel Rechenzeit,

gute Trainingsdaten,

Entwicklerinnen und Entwickler, die neue und bekannte Algorithmen klug auswählen, kombinieren und weiterentwickeln,

menschliche Klickworkerinnen und Klickworker, die Ergebnisse bewerten oder Trainingsdaten filtern, damit keine unerwünschten Inhalte erlernt werden, wie z. B. potenziell verstörende Texte.

Klar ist, dass dazu also auch viel Geld nötig ist, das irgendwie auch erwirtschaftet oder bereitgestellt werden muss.

Hinter ChatGPT steht das Unternehmen OpenAI. Mit LaMDA (Language Models for Dialog Applications) sorgte Google im Juni 2022 für Aufsehen, als ein Mitarbeiter einen Chat veröffentlichte mit der Behauptung LaMDA habe ein Bewusstsein. Luminous ist der Chatbot, den das europäische Unternehmen alephAlpha seit April 2022 zur kommerziellen Nutzung anbietet. Den Chatbot LLaMa (Large Language Model Meta AI) hat der meta-Konzern im Februar 2023 vorgestellt.

Informationen der Anbieter einiger dieser Systeme finden Sie beispielhaft nachfolgend:

Antwort ChatGPT: „Chatbots werden in vielen Bereichen eingesetzt, darunter Kundenservice, E-Commerce, Bildung und Unterhaltung. Sie können dazu beitragen, die Effizienz von Prozessen zu verbessern und den Kundenservice zu verbessern.“

Blättern Sie hier, um einige konkrete KI-Systeme, die Chatbots bereits jetzt einsetzen, kennenzulernen:

Der Semmi-Robot und Semmi-Avatar wurden von der Deutschen Bahn entwickelt, um Kundenfragen zu beantworten, z.B. für Fahrplanauskünfte.

Die Bundesbots des ITZBund (InformationsTechnikZentrum Bund) beantworten Fragen von Bürgerinnen und Bürgern z.B. zu Covid-19, zur Kfz-Steuer oder zur Warn-App Nina.

Luminous hilft im Bürgerservice der Stadt Heidelberg z. B. bei Fragen wie „Perso weg“.

Ada nimmt Symptome auf, erstellt eine Diagnose und gibt einen medizinischen Rat.

Bei textbasierten Systemen ist deutlich erkennbar, dass das Gegenüber ein Chatbot ist. Kombiniert man die textbasierten Chatbots mit einer Spracherkennungssoftware, einer Sprachausgabe und einer graphischen Darstellung des virtuellen Gesprächspartners, so erhält man Avatare, also mehr oder weniger menschenähnliche Roboter, die täuschend echt kommunizieren können. Verwendet man statt einer graphischen Darstellung ein Foto oder Video des Gesprächspartners, entstehen Deepfakes, die leicht den Eindruck eines tatsächlich aufgenommenen Videos erwecken.

Blättern Sie hier, um einige Beispiele für täuschend echte Gesprächspartner kennenzulernen:

Kuki, die virtuelle Influencerin

Googles Duplex vereinbart Friseurtermine

AVASAG liefert automatische Gebärdenübersetzung

Falscher Klitschko als Deepfake

Kuki wurde designt um Menschen zu unterhalten, z. B. als virtuelle Influencerin. Wenn Sie mögen: chatten Sie mit Kuki, besuchen Sie ihren Youtube-Kanal oder folgen Sie ihr auf Instagram oder twitter.

Googles Duplex vereinbart Friseurtermine oder macht Tischreservierungen per Telefon.

Mit AVASAG soll ein Avatar-basierter Sprachassistent zur automatischen Gebärdenübersetzung entstehen.

Möglich sind Interviewpartner, die Aussehen, Sprache und Mimik einer realen Person nachahmen, also täuschend echte Deepfakes sind, mit weit reichenden Folgen z. B. in der Verbreitung von Fake News.

Ein Chatbot arbeitet zuverlässig 7/24, bleibt geduldig und höflich, beantwortet einfache Fragen schnell und präzise, zeigt sich als anregender Chatpartner, fasst Texte in einfacher Sprache zusammen u. v. m. Dies kann in Zeiten von Fachkräftemangel helfen, Menschen für das einzusetzen, wo sie wirklich gebraucht werden: bei komplexen Fragen, um genau zuzuhören und für den menschlichen Umgang.

Auch beim Lehren und Lernen lassen sich Chatbots einsetzen. Beispielsweise können KI-gestützte Systeme häufig gestellte Fragen von Lernenden beantworten, ein in die Homepage integrierter Chatbot kann Eltern bei organisatorischen Fragen unterstützen oder ein Chatbot als Lernprogramm kann individueller Lernberater sein. Im besten Fall werden Lehrkräfte entlastet und erhalten mehr Zeit für pädagogische Arbeit.

Chatbots und einige Risiken

Bei der Auswahl und dem Einsatz KI-gestützter Tools ergeben sich jedoch auch Risiken.

Chatbots und die zugrunde liegenden Sprachmodelle können dazu führen, dass Fake News noch einfacher, schneller und täuschender verbreitet werden können, z. B. durch Bots in sozialen Netzwerken, die durch künstliche Intelligenz selbständig auf Posts antworten können oder Deep Fakes, die falsche Informationen in Videos glaubhaft erscheinen lassen. Auch Phishing-Mails dürften noch leichter täuschen können, wenn sie mit Hilfe eines solchen Chatbots noch individueller und besser formuliert sein werden und zur Herausgabe von Passwörtern oder Download von Schadsoftware verleiten.

Nicht zu vernachlässigen ist auch der immense Energiebedarf der aktuellen Chatbot-Generation. Zum einen ist Energie nötig für den Rechner der nutzenden Person, das Netzwerk und den Server, auf dem der Chatbot läuft. Zum anderen sind auch zum Trainieren eines Sprachmodells enorme Rechenkapazitäten nötig, bei ChatGPT z. B. sollen dafür 500 Tonnen Kohlendioxid ausgestoßen worden sein.

Bei der Nutzung ergeben sich auch weitreichende juristische Fragen: Wie kann sicher gestellt werden, dass Datenschutz auch im Umgang mit KI-gestützten Systemen gilt? Fragen wie „Was passiert, wenn ich in eine Gesundheits-App meine aktuellen Symptome eingebe, im Chat einer Bankseite meinen Kreditwunsch schildere oder beim Bürgerservice schildere, dass ich meinen Personalausweis verloren habe?” machen deutlich, dass es sehr wohl wichtig ist, ob die Angaben aus einer Anfrage nur genutzt werden um eine passgenaue Antwort zu erhalten oder ob damit auch der Chatbot trainiert wird, der folglich diese Daten später einem anderen Nutzer auf seine Anfrage hin ausgeben kann. Auch wie mit urheberrechtlich geschützten Texten als Trainingsdaten umzugehen ist, ist juristisch umstritten. Erschwerend kommt dazu, dass datenschutzrechtliche und urheberrechtliche Fragen nicht überall auf der Welt gleich bewertet werden.

Einen guten Überblick über juristische Fragen finden Sie hier:

Sind Chatbots ein Schritt hin zu starker KI?

Solange wir existierende Chatbots auf ihren praktischen Nutzen hin betrachten, können wir sachlich über Vor- und Nachteile diskutieren und sie als das nehmen was sie sind: Maschinen, die in manchen Bereichen Menschen überlegen sind, Fachleute sprechen von „schwacher KI“. Betrachten wir aber die Entwicklung hin zu immer menschenähnlicherem Verhalten, erscheint die Frage berechtigt ob hier Maschinen entstehen, die Menschen in allen Bereichen überlegen sind, also ob hier eine „starke KI“ entsteht oder zumindest etwas, was dafür gehalten werden kann (Notter et al., o. J.).

Ob es jemals Systeme geben wird, die wir als starke KI bezeichnen würden, ist nicht geklärt. Sicher ist aber, dass wir als Gesellschaft auf die Entwicklungen Einfluss nehmen sollten, solange wir (noch) können. KI sollte also nur so stark sein dürfen, wie wir sie lassen.

Lesen Sie mehr über diese Fragen hier im Magazin in den Artikeln Was ist KI und Starke KI.

Textgenerierende Systeme werden für Lehrkräfte und Schülerinnen und Schüler immer einfacher zur Verfügung stehen.

Das StMUK hat als Unterstützung für Schulen Hinweise zum Umgang mit KI-Technologien zusammengestellt und aktualisiert diese fortlaufend. Zielgruppe sind Lehrkräfte und Erziehungsberechtigte.

Das ISB hat in einer Handreichung die Auswirkungen von KI auf das Arbeiten im W-Seminar sowie praktische Hinweise für Lehrkräfte zusammengestellt.

Im Rahmen des Projekts KI@school entstand eine Handreichung zur Verwendung von ChatGPT im Mathematikunterricht.

Weitere Einblicke in aktuelle Diskussionen über die Bedeutung von textgenerierenden Systemen für den Bildungssektor erhalten Sie z. B. hier:

Einen Überblick über Informationen, Ideen und Praxisbeispiele zum Einsatz von Chatbots im Unterricht finden Sie im mebis Magazin-Beitrag „Lernförderliche Gestaltung digitaler Medien”:

Zahlreiche Materialien für den Unterricht, in dem Chatbots lernförderlich durch die Lernenden eingesetzt werden, finden Sie hier zusammengestellt:

Das ZDF hat einen Chatbot entwickelt, der spielerisch politische Bildung fördert: im Gespräch mit dem Chatbot legt der Spieler Regeln für das Leben auf der Insel fest und erhält sofort Feedback vom Chatbot und den Inselbewohnern. Das Spiel lässt Mechanismen deutlich werden, die freie Gesellschaften bedrohen können.

Zielgruppe: 5.-10. Jahrgangsstufe

Art des Materials: Selbstlernmaterial

Link zum Material: https://deine-insel.zdf.de/

Carolin Donhauser-Buchmaier und Michael Rödel (Professur für Didaktik der deutschen Sprache und Literatur) haben für die Stiftung Bildungspakt Bayern eine „Handreichung für den Einsatz von KI in Schülerhand” erstellt. Das Dokument enthält Beispiele für Schreibeinheiten, didaktische Erläuterungen und eine Literaturliste.

Zielgruppe: Lehrkräfte des Faches Deutsch

Art des Materials: Beispiele für den Unterricht

Link zum Material: https://bildungspakt-bayern.de/wordpress/wp-content/uploads/2025/05/Handreichung-Deutsch.pdf

Gemeinsam mit der Didaktik der Mathematik an der Universität Siegen hat die Stiftung Bildungspakt Bayern eine anschauliche Untersuchung der Möglichkeiten von Sprachmodellen für den Mathematikunterricht erstellt. Neben Beispielen für den Unterricht werden „Grundbedingungen für sinnhaftes Prompten” dargestellt. Ergänzt werden die praxisnahen Ausführungen durch eine Literaturliste.

Zielgruppe: Lehrkräfte des Faches Mathematik

Art des Materials: Impulse für den Unterricht

Link zum Material: https://www.bildungspakt-bayern.de/wordpress/wp-content/uploads/2025/06/250625_SprachmodelleMathe_Bildungspakt_05.pdf

Jan Hartwig stellt ein h5p-Element bereit, mit dem Schülerinnen und Schüler interaktiv einen Leitfaden für das Prompting in ChatGPT erarbeiten. (Hilfe zum Einbinden von h5p-Elementen in mebis findet sich im ByCS-Beitrag „h5p in mebis” https://mebis.bycs.de/kategorien/bycs-tools-im-unterricht/lernplattform-in-der-praxis/h5p-support-bereich .)

Zielgruppe: ab 8. Jahrgangsstufe

Art des Materials: Selbstlernmaterial

Link zum Material: https://mundo.schule/details/SODIX-0001093482

Die Siemensstiftung hat Aufgaben aus verschiedenen Fachgebieten und mit verschiedenen Schwierigkeitsgraden entwickelt, mit denen die Lernenden in Gruppen Prompts entwickeln, bewerten und verbessern.

Zielgruppe: ab 8. Jahrgangsstufe

Art des Materials: Arbeitsblatt

Link zum Material: https://mundo.schule/details/DE.SIEMENSSTIFTUNG.114799

Die Siemensstiftung hat auf einem Arbeitsblatt Beispiele zusammengestellt, bei denen ChatGPT falsche Antworten liefert (Stand Juli 2023). Die Lernenden sollen erkennen, dass die Antworten von ChatGPT immer fachlich geprüft werden müssen.

Zielgruppe: ab 8. Jahrgangsstufe

Art des Materials: Arbeitsblatt

Link zum Material: https://mundo.schule/details/DE.SIEMENSSTIFTUNG.114798

Die Siemensstiftung hat ein Paket von interaktiven Übungen rund um das Thema Künstliche Intelligenz und ChatGPT erstellt.

Zielgruppe: ab 8. Jahrgangsstufe

Art des Materials: Selbstlernmaterial

Link zum Material: https://mundo.schule/details/DE.SIEMENSSTIFTUNG.114784

Um die immer einfacher zugänglichen textgenerierenden Systeme bewerten und also kompetent und verantwortungsvoll nutzen zu können, müssen die Lernenden Wissen über solche Systeme erwerben.

Im Folgenden sind Unterrichtsideen und -materialien vorgestellt, die dieses Ziel verfolgen.

In knapp 11 min erklärt die Sendung mit der Maus hervorragend, wie Digitale Sprachassistenten funktionieren.

Zielgruppe: ab Grundschule

Art des Materials: Video

Link zum Material: https://www.wdrmaus.de/extras/mausthemen/digitalisierung/filme/digitaler_sprachassistent.php5

In einem knapp 4minütigen KI-generierten Video wird erklärt, wie eine KI Musik macht.

Zielgruppe: ab 5. Jahrgangsstufe

Art des Materials: Video

Link zum Material: https://kinder.wdr.de/tv/die-sendung-mit-der-maus/av/ki-maeleon-100.html

In einem knapp 6minütigen Video erklärt die Sendung mit der Maus wie eine KI aus Texten „lernt” und dann selbst Texte erzeugen kann.

Zielgruppe: ab 5. Jahrgangsstufe

Art des Materials: Video

Link zum Material: https://kinder.wdr.de/tv/die-sendung-mit-der-maus/av/wie-schreibt-eine-ki-texte-100.html

Die bpb berichtet in diesem Artikel in einfacher Sprache über Künstliche Intelligenz und insbesondere auch Sprachassistenten.

Der Artikel liegt auch in Hörfassung vor.

Zielgruppe: ab 5. Jahrgangsstufe

Art des Materials: Text, Audio

Link zum Material: https://www.bpb.de/themen/politisches-system/politik-einfach-fuer-alle/301230/kuenstliche-intelligenz/

In diesem teachSHARE-Kurs von Dunja Speckner wird ausgehend von ChatGPT die Unterscheidung Chatbot und KI geklärt sowie eine kurzer Abriss der Geschichte der künstlichen Intelligenz gegeben. Abschließend programmieren die Schülerinnen und Schüler einen eigenen einfachen Chatbot.

Zielgruppe: Informatik-Unterricht ab 5. Jahrgangsstufe

Art des Materials: Unterrichtsmaterial

Link zum Material: https://lernplattform.mebis.bycs.de/blocks/mbsteachshare/coursedetail.php?courseid=1350234

In einer Recherche geht das Team von neuneinhalb ganz praktisch der Frage nach, ob ein neuneinhalb-Beitrag auch von einer Maschine, z. B. Luminous, erstellt werden könnte.

Zielgruppe: ab Sekundarstufe I

Art des Materials: Video

Link zum Material: https://kinder.wdr.de/tv/neuneinhalb/av/video-fernsehen-der-zukunft--das-neuneinhalb-ki-experiment-100.html

Eric Mayer von pur+ erklärt in einem kurzen (2 min) Beitrag den Lexikon-Eintrag „Chatbot”.

Zielgruppe: ab 5. Jahrgangsstufe

Art des Materials: Video

Link zum Material: https://www.br.de/sogehtmedien/lexikon-chatbots-102.html

Das Team von AI unplugged hat das Unterrichtsmaterial von CS-Unplugged übersetzt und adaptiert. Die Lernenden spielen darin damit in einem Frage-Antwort-Spiel den Turing-Test nach.

Zielgruppe: ab 5. Jahrgangsstufe

Art des Materials: Unterrichtsmaterial

Link zum Material: https://computingeducation.de/proj-ai-unplugged/

Das ZDF gibt in einem Video einen Überblick über Entwicklung, Chancen und Risiken von Chatbots.

Zielgruppe: ab Sekundarstufe I

Art des Materials: Video

Link zum Material: https://download.sodix.de/api/content/data/SODIX-0001104743.mp4

In der Reihe „Informatik im Kontext“ stellt die Universität Bayreuth einen Unterrichtsentwurf von Helmut Witten und Malte Hornung zum Thema Chatbots für die Sekundarstufe 1 zur Verfügung.

Zielgruppe: Sekundarstufe 1

Art des Materials: Unterrichtsentwurf

Link zum Material: https://medienwissenschaft.uni-bayreuth.de/inik/entwuerfe/chatbots/

ki-campus stellt Arbeitsblätter und H5P-Übungen für den Unterricht zur Verfügung, um die Lernenden Kenntnisse über KI-gesteuerte Umgebungen und Anwendungsbereiche der KI erarbeiten zu lassen.

Zielgruppe: 7.-10. Jahrgangsstufe

Art des Materials: Unterrichtsmaterial

Link zum Material: https://ki-campus.org/exercises/science-fiction

Nach einem Login bei ki-kurs.org stehen den Lernenden ein Video und daran anschließende Fragen zur Verfügung.

Zielgruppe: ab 8. Jahrgangsstufe

Art des Materials: Video, Unterrichtsmaterial

Link zum Material: https://ki-kurs.org/app/ethics/course=ki_and_society/chapter=3/id=1

Die bpb stellt in einem Themenblatt „Quelle: Künstliche Intelligenz” unter anderem ein Arbeitsblatt zum kritischen Umgang mit KI-generierten Texten und Präsentationen zur Verfügung.

Zielgruppe: ab 8. Jahrgangsstufe

Art des Materials: Arbeitsblatt mit methodischen Hinweisen für die Lehrperson

Link zum Material: https://www.bpb.de/shop/materialien/themenblaetter/552426/quelle-kuenstliche-intelligenz/

Mit SoekiaGPT von Michael Hielscher lässt sich die Funktionsweise eines Sprachmodells schrittweise durchspielen. Die zugehörige Handreichung für Lehrkräfte enthält ganz konkrete Hinweise zu möglichen Aufgabenstellungen zu SoekiaGPT.

Zielgruppe: ab 8. Jahrgangsstufe

Art des Materials: Unterrichtsmaterial

Link zum Material: https://www.soekia.ch/gpt.html

In „TURING-BUS - Sammlung offener Lehrmaterialien“ stellen Dr. Andrea Knaut und Katinka Richter Material zu einem Workshop zur Verfügung.

Zielgruppe: ab 9. Jahrgangsstufe

Art des Materials: Unterrichtsmaterial

Link zum Material: https://turing-bus.de/fileadmin/user_upload/Turing-Bus_2022/Turing-Bus_OER.pdf

Nach einem Login bei ki-kurs.org steht den Lernenden ein Them-O-Mat zur Verfügung um dort einen „Rat der Denkenden“ über ein gewähltes Thema beraten zu lassen, z. B. Pflegeroboter. Interaktiv betrachten die Lernenden die Thematik aus verschiedenen Blickwinkeln um zu einem differenzierten Urteil zu kommen.

Zielgruppe: ab 10. Jahrgangsstufe

Art des Materials: Unterrichtsmaterial

Link zum Material: https://ki-kurs.org/app/auth?/ethics/ethically-questionable/coursepath=1

Lesen Sie hier, welche wichtigen Meilensteine aber auch Rückschläge die KI im Laufe der letzten Jahrzehnte erfahren hat.

Kurze Informationen und Hinweise für den Unterricht

Wenn Maschinen Augen bekommen: Erfahren Sie in diesem Artikel mehr darüber, wie Bilderkennungstechnologien unser tägliches Leben beeinflussen und welche Auswirkungen dies auf unsere Zukunft haben könnte.

Erfahren Sie mehr über das Potenzial starker Künstlicher Intelligenz (KI), die ähnlich einem menschlichen Gehirn eigenständig denken und lernen kann.

Es gibt kaum ein Thema, das in den letzten Jahren eine solche Relevanz in allen Lebensbereichen entwickelt hat wie die Künstliche Intelligenz. Erfahren Sie hier, was genau hinter der Künstlichen Intelligenz und hinter schwacher und starker KI steckt.

Textbasierte KI-Technologien didaktisch zielführend im Unterricht einsetzen - Ideen und Beispiele